PostgreSQLエンタープライズ・コンソーシアム 技術部会 WG#3

WG3活動報告書

レプリケーション調査編

2

8

9

10

10

10

10

10

11

12

12

12

12

12

12

12

12

13

13

13

13

13

14

14

14

14

15

15

15

17

18

18

18

23

23

25

26

27

30

30

30

30

31

31

31

32

34

34

36

36

36

36

37

37

38

38

38

目次目次

目次

1. 改訂履歴

2. ライセンス

3. はじめに

3.1. PostgreSQLエンタープライズコンソーシアムとWG3について

3.2. 本資料の概要と目的

3.3. 本資料の構成

3.4. 想定読者

3.5. 参考文献

4. PostgreSQLにおけるレプリケーション

4.1. レプリケーションの目的

4.1.1. 可用性の向上

4.1.2. 性能向上

4.1.2.1. 参照の同期

4.1.2.2. 更新による一貫性の維持

4.2. 代表的なレプリケーションの手法

4.2.1. シングルマスタ

4.2.1.1. ストレージレプリケーション

4.2.1.2. トリガベースレプリケーション

4.2.1.3. クエリベースレプリケーション

4.2.1.4. ストリーミングレプリケーション

4.2.1.5. ロジカルレプリケーション

4.2.2. マルチマスタ

4.2.2.1. Bi-Directional Replication

4.2.2.2. Bucardo

4.3. 参考文献

5. ストリーミングレプリケーション

5.1. はじめに

5.1.1. PostgreSQLのストリーミングレプリケーションの特徴

5.1.2. 検証を実施したSR構成

5.2. SR環境構築時の設定項目、推奨値

5.2.1. SRにおける目的別の設定

5.2.2. SRの基本設定手順(2ノード)

5.2.3. スレーブの追加

5.2.4. アーカイブモード運用

5.2.5. レプリケーションスロット

5.2.6. 【参考情報】同期モードにおけるパフォーマンスへの影響

5.2.7. 遅延レプリケーション

5.2.8. WAL圧縮

5.3. SR環境の監視

5.3.1. レプリケーション操作ログの監視

5.3.1.1. 調査の目的

5.3.1.2. 調査結果

5.3.1.3. 調査結果

5.3.2. 同期状況の監視

5.3.2.1. 同期遅延監視

5.3.3. 更新、読み取りの監視

5.3.3.1. 更新・読取監視

5.3.4. スプリットブレインの監視

5.3.4.1. スプリットブレインの定義と調査の目的

5.3.4.2. 監視方法

5.3.4.3. サーバログの監視

5.3.4.4. pg_controldataコマンドによる監視

5.3.4.5. pg_control_recoveryコマンドによる監視

5.3.4.6. pg_is_in_recovery関数による監視

5.4. SR環境の障害時運用

5.4.1. 本文書における用語の定義

PostgreSQL Enterprise Consortium

Page 2 of 285

38

38

39

39

40

41

42

46

47

50

51

52

54

59

60

63

65

65

65

66

67

67

72

76

83

83

87

91

91

94

97

104

106

106

109

109

109

109

109

110

110

111

111

111

111

112

112

117

117

117

117

117

119

119

119

119

120

123

123

5.4.1.1. フェイルオーバ

5.4.1.2. フェイルバック

5.4.1.3. スイッチオーバ

5.4.1.4. スイッチバック

5.4.2. 障害時運用手順(2ノード構成)

5.4.2.1. フェイルオーバ

5.4.2.2. フェイルバック

5.4.2.3. スイッチオーバ

5.4.2.4. スイッチバック

5.4.2.5. スレーブ障害による対処

5.4.3. 障害時運用手順(複数スレーブ)

5.4.3.1. フェイルオーバ(複数スレーブ)

5.4.3.2. フェイルバック(複数スレーブ)

5.4.3.3. スイッチオーバ(複数スレーブ)

5.4.3.4. スイッチバック(複数スレーブ)

5.4.3.5. スレーブ障害による対処(複数スレーブ)

5.4.4. 障害時運用手順(カスケード構成)

5.4.4.1. フェイルオーバ

5.4.4.2. 同期スレーブへのフェイルオーバ

5.4.4.3. 非同期スレーブへのフェイルオーバ

5.4.4.4. フェイルバック

5.4.4.5. 旧マスタを同期モードスレーブとしてフェイルバック

5.4.4.6. 旧マスタをインスタンス障害からフェイルバック

5.4.4.7. 旧マスタ/旧スレーブ1をフェイルバック

5.4.4.8. スイッチオーバ

5.4.4.9. 同期スレーブへのスイッチオーバ

5.4.4.10. 非同期スレーブへのスイッチオーバ

5.4.4.11. スイッチバック

5.4.4.12. 同期モードスレーブからマスタへのスイッチバック

5.4.4.13. 非同期モードスレーブからマスタへのスイッチバック

5.4.4.14. pg_rewindを使用したスイッチバック

5.4.4.15. スレーブ障害による対処

5.5. まとめ

5.5.1. SR機能拡張の歴史

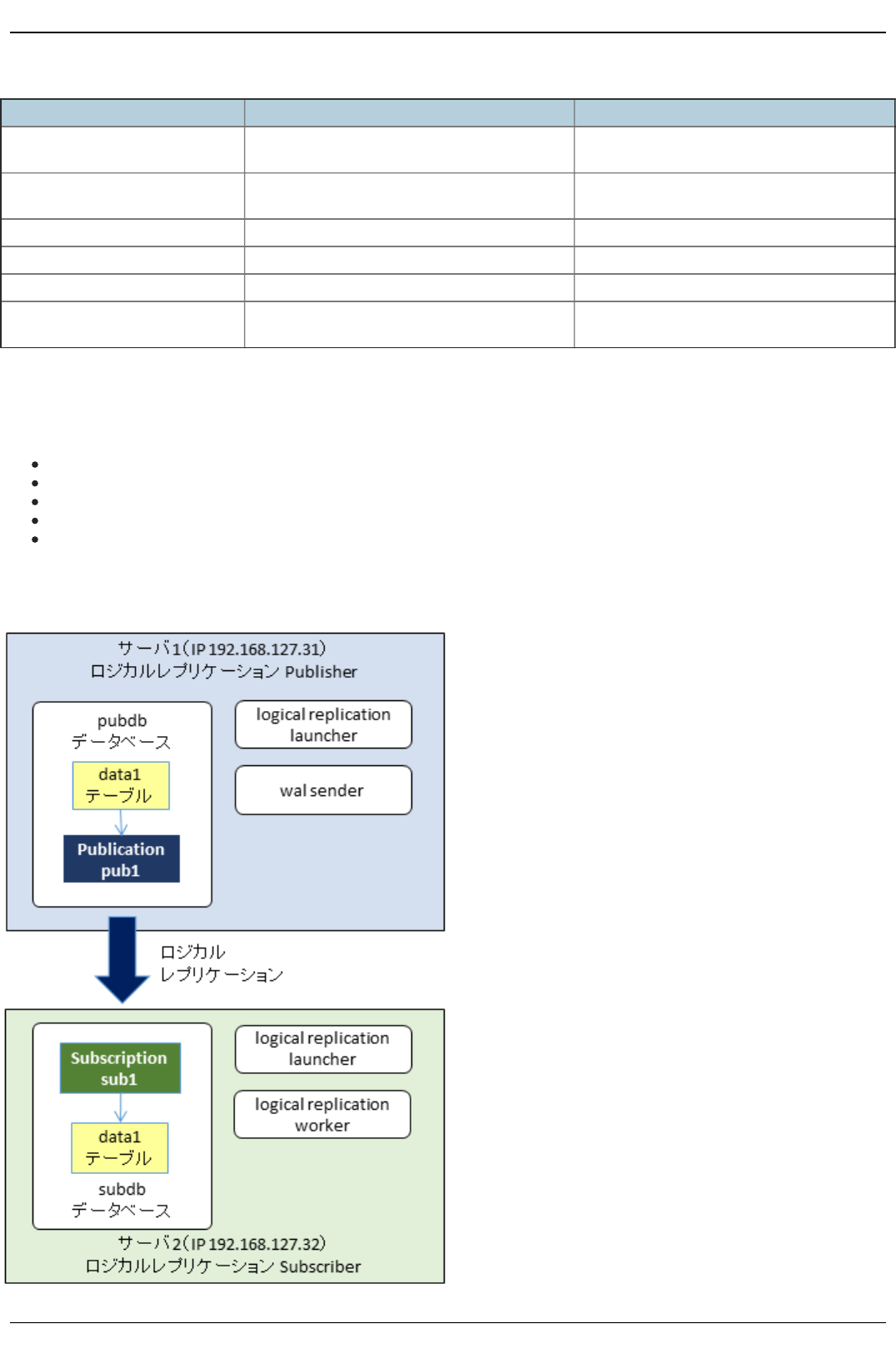

6. ロジカルレプリケーション

6.1. ロジカルレプリケーションの概要

6.1.1. 概要

6.1.2. 特徴

6.1.3. アーキテクチャ

6.1.4. ユースケース

6.1.5. 制限事項

6.2. ロジカルレプリケーションの設定

6.2.1. データベース単位の設定

6.2.1.1. 検証目的

6.2.1.2. 検証内容

6.2.1.3. 検証環境

6.2.1.4. 検証手順

6.2.2. テーブル単位の設定

6.2.2.1. 検証目的

6.2.2.2. 検証内容

6.2.2.3. 検証環境

6.2.2.4. 検証手順

6.2.3. レプリケーション対象とする更新処理の限定

6.2.3.1. 検証目的

6.2.3.2. 検証内容

6.2.3.3. 検証環境

6.2.3.4. 検証手順

6.2.4. 設定するパラメータ

6.2.4.1. 実行時パラメータ

PostgreSQL Enterprise Consortium

Page 3 of 285

124

129

130

130

130

130

130

131

134

134

135

135

135

141

141

141

141

142

150

150

150

150

151

156

156

156

156

156

169

169

169

170

170

172

174

174

177

178

178

179

185

187

189

191

191

192

194

195

197

198

199

200

201

202

203

204

204

205

206

6.2.4.2. 実行時パラメータと起動プロセスの関係

6.2.4.3. 考察

6.3. ロジカルレプリケーションの応用

6.3.1. primary keyが定義されていないテーブルのレプリケーション設定

6.3.1.1. 検証目的

6.3.1.2. 検証内容

6.3.1.3. 検証環境

6.3.1.4. 検証手順

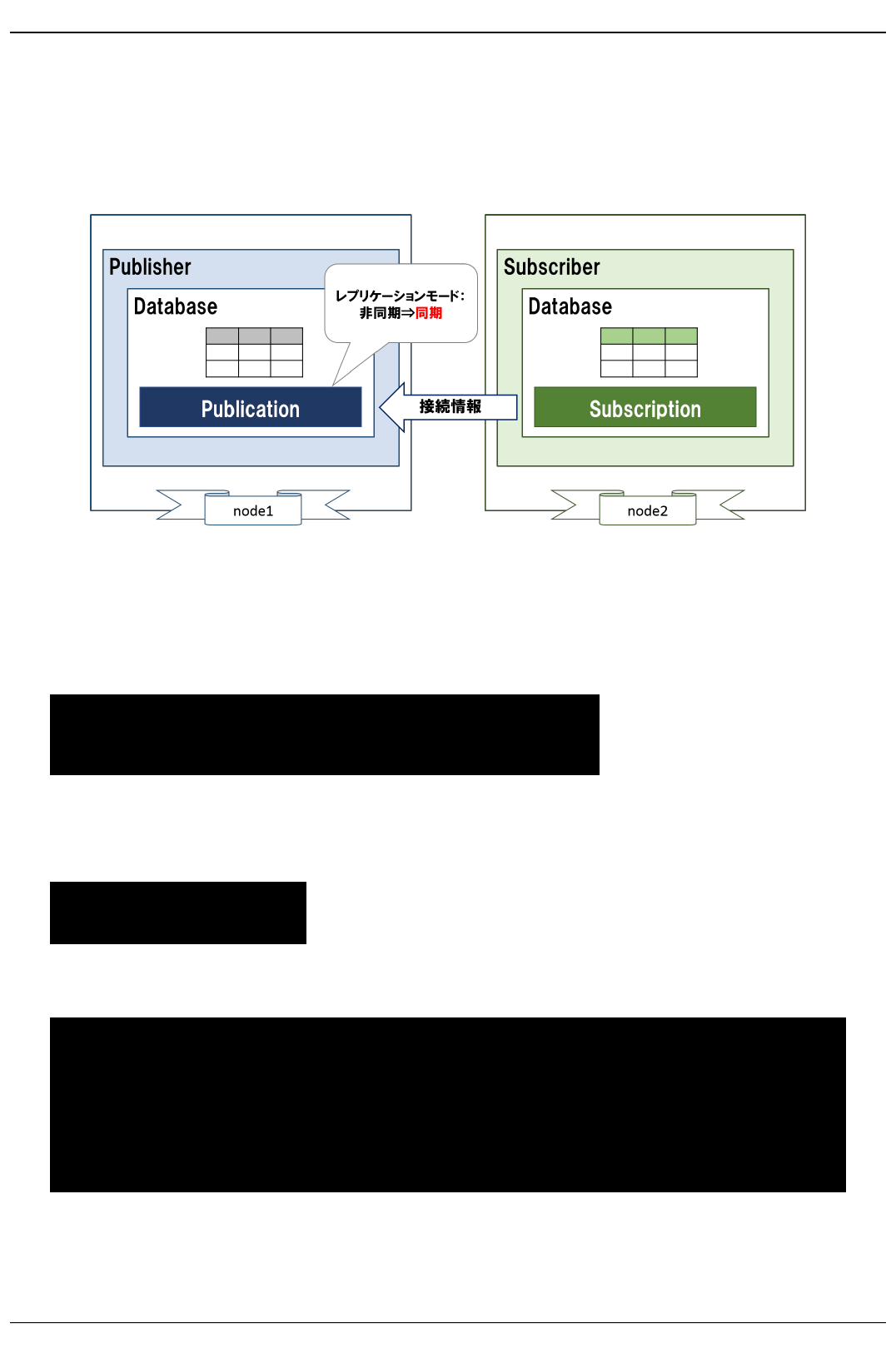

6.3.2. 同期レプリケーション

6.3.2.1. 検証目的

6.3.2.2. 検証内容

6.3.2.3. 検証環境

6.3.2.4. 検証手順

6.3.3. 複数サブスクリプション

6.3.3.1. 検証目的

6.3.3.2. 検証内容

6.3.3.3. 検証環境

6.3.3.4. 検証手順

6.3.4. カスケード構成

6.3.4.1. 検証目的

6.3.4.2. 検証内容

6.3.4.3. 検証環境

6.3.4.4. 検証手順

6.3.5. パーティショニングとの組み合わせ

6.3.5.1. 検証構成

6.3.5.2. 組み合わせた場合の利点

6.3.5.3. 検証内容

6.3.5.4. 検証結果

6.4. ロジカルレプリケーションの運用

6.4.1. 監視

6.4.1.1. 前提とする環境

6.4.1.2. ロジカルレプリケーションの設定

6.4.1.2.1. Publisherで確認できる情報

6.4.1.2.2. Subscriberで確認できる情報

6.4.1.3. ロジカルレプリケーションの稼働状態

6.4.1.3.1. Publisherで確認できる情報

6.4.1.3.2. Subscriberで確認できる情報

6.4.2. 障害時の動作確認

6.4.2.1. 前提とする環境

6.4.2.2. 障害ケース1 ロジカルレプリケーション関連プロセスの異常終了

6.4.2.3. 障害ケース2 Publisherのノード停止

6.4.2.4. 障害ケース3 Subscriberのノード停止

6.4.2.5. 障害ケース4 Publisher/Subscriber間のネットワーク断絶

6.4.3. レプリケーション対象テーブルの追加/削除

6.4.3.1. 前提とする環境

6.4.3.2. レプリケーション対象のテーブルを追加する手順(データベース単位のPublication)

6.4.3.3. レプリケーション対象のテーブルを追加する手順(テーブル単位のPublication)

6.4.3.4. レプリケーション対象のテーブルを変更する手順

6.4.3.5. レプリケーション対象のテーブルにインデックスを追加する手順

6.4.4. レプリケーション対象外となる操作、オブジェクト

6.4.4.1. 前提とする環境

6.4.4.2. TRUNCATE

6.4.4.3. シーケンス

6.4.5. 更新競合時の動作

6.4.5.1. 前提とする環境

6.4.5.2. 更新時の競合発生と解消

6.4.5.2.1. 主キー違反/一意キー違反

6.4.5.2.2. CHECK制約違反

6.4.5.2.3. 更新データが存在しない

PostgreSQL Enterprise Consortium

Page 4 of 285

207

207

209

211

212

213

214

214

215

215

215

215

216

217

217

218

218

221

221

222

222

230

231

232

232

232

232

232

232

233

233

234

234

234

235

235

235

235

235

236

241

241

241

241

241

241

241

243

247

247

247

247

247

249

250

250

250

250

250

6.4.5.2.4. 削除データが存在しない

6.4.5.2.5. テーブルが存在しない

6.4.5.2.6. 一部の列が存在しない

6.4.5.2.7. データ型変換エラー

6.4.5.2.8. テーブルのロック

6.4.5.2.9. 更新対象レコードのロック

6.4.5.3. 初期データ同期時の競合発生と解消

6.4.5.3.1. 主キー違反/一意キー違反

6.4.5.3.2. CHECK制約違反

6.4.5.3.3. 更新データが存在しない

6.4.5.3.4. 削除データが存在しない

6.4.5.3.5. テーブルが存在しない

6.4.5.3.6. 一部の列が存在しない

6.4.5.3.7. データ型変換エラー

6.4.5.3.8. テーブルのロック

6.4.5.3.9. 更新対象レコードのロック

6.4.5.4. WALのスキップによる競合の解消

6.4.6. ストリーミングレプリケーションとの併用

6.4.6.1. 前提とする環境

6.4.6.2. ストリーミングレプリケーションを併用する環境の構築手順

6.4.6.3. ストリーミングレプリケーションを併用する環境で障害が発生した場合の運用手順

6.4.6.4. 考察

6.5. まとめ

7. Bi-Directional Replication (BDR)

7.1. はじめに

7.1.1. BDRの特徴

7.1.1.1. BDRとは

7.1.1.2. ユースケース

7.1.1.3. メカニズム

7.1.1.4. 整合性

7.1.1.5. シーケンス

7.1.1.6. 比較表

7.1.1.7. サポート

7.2. 調査、検証の目的

7.3. 調査、検証の前提

7.4. BDR環境構築時の設定と設定手順

7.4.1. BDR環境の設定手順

7.4.1.1. 概要

7.4.1.2. 対象試験サーバ

7.4.1.3. 事前確認

7.5. BDR動作検証

7.5.1. ノードの追加・切り離し

7.5.1.1. 検証の目的

7.5.1.2. 検証内容

7.5.1.3. 検証環境

7.5.1.4. 検証手順

7.5.1.4.1. ノード切り離し

7.5.1.4.2. ノード追加

7.5.1.5. 検証結果

7.5.2. グローバルシーケンス設定

7.5.2.1. 検証の目的

7.5.2.2. 検証環境

7.5.2.3. 検証手順

7.5.2.4. 検証結果

7.5.3. 選択的レプリケーション

7.5.3.1. 検証目的

7.5.3.2. 検証内容

7.5.3.3. 検証環境

7.5.3.4. 検証手順

PostgreSQL Enterprise Consortium

Page 5 of 285

254

254

254

254

255

255

256

264

265

268

269

270

272

272

272

272

272

272

272

275

278

278

278

278

278

278

279

279

281

282

282

282

282

283

284

285

7.5.3.5. 検証結果

7.5.4. 更新処理競合時の動作

7.5.4.1. 検証目的

7.5.4.2. 検証内容

7.5.4.3. 検証環境

7.5.4.4. 検証手順

7.5.4.4.1. PRIMARY KEYまたはUNIQUE制約

7.5.4.4.2. 外部キー制約

7.5.4.4.3. 排他制約

7.5.4.4.4. グローバルなデータ

7.5.4.4.5. ロックの競合とデッドロックの中断

7.5.4.4.6. その他

7.5.4.5. 検証結果

7.5.5. ノード障害と復旧

7.5.5.1. 検証の目的

7.5.5.2. 検証内容

7.5.5.3. 検証環境

7.5.5.4. 検証手順

7.5.5.4.1. ノード障害

7.5.5.4.2. ノード復旧

7.5.5.5. 検証結果

7.5.5.6. 備考

7.6. BDR性能検証

7.6.1. 更新性能検証結果

7.6.1.1. 検証目的

7.6.1.1.1. 検証内容

7.6.1.1.2. 検証環境

7.6.1.1.3. 検証手順

7.6.1.1.4. 検証結果

7.7. まとめ

7.7.1. BDR検証まとめ

7.8. 参考文献

7.8.1. 関数一覧

7.8.2. システムカタログ一覧

8. まとめ

9. 著者

PostgreSQL Enterprise Consortium

Page 6 of 285

PostgreSQL Enterprise Consortium

Page 7 of 285

1. 改訂履歴改訂履歴

版版 改訂日改訂日 変更内容変更内容

1.0 2017/06/20 2016年度版として新規作成

- Postg reSQ L 9.6 を対象バージョンとする

2.0 2018/04/11 2017年度版として主に以下の章を加筆修正

- 5章 ストリーミングレプリケーション

Po stgreSQ L 10 に対応

複数スレーブ対応 (1.0版では2ノードに限定していた)

- 6章 ロジカルレプリケーションの追加

Po stgreSQ L 10 の新機能として追加

PostgreSQL Enterprise Consortium

Page 8 of 285

2. ライセンスライセンス

本作品はCC-BYライセンスによって許諾されています。 ライセンスの内容を知りたい方は こちら でご確認ください。 文書の内容、表記に関する誤り、ご要望、感想等につ

きましては、PGEConsのサイト を通じてお寄せいただきますようお願いいたします。

Eclip seは、Eclip se Fo u n d atio n Incの米国、およびその他の国における商標もしくは登録商標です。

IBM およびDB 2は、世界の多くの国で登録されたIn tern ation al B u sin ess Mach in es Corp oration の商標です。

In tel、インテルおよびXeo n は、米国およびその他の国における In tel Corp ora tion の商標です。

Javaは、O racle Corp o ration 及びその子会社、関連会社の米国及びその他の国における登録商標です。 文中の社名、商品名等は各社の商標または登

録商標である場合があります。

Lin u x は、Linu s To rvald s 氏の日本およびその他の国における登録商標または商標です。

Red H atおよびSh ad ow man log o は、米国およびその他の国におけるRed Hat,In c.の商標または登録商標です。

Microso ft、W ind o w s Server、SQ L Server、米国 M icro soft Co rp oration の米国及びその他の国における登録商標または商標です。

MySQ Lは、O racle Corp o ration 及びその子会社、関連会社の米国及びその他の国における登録商標です。 文中の社名、商品名等は各社の商標または

登録商標である場合があります。

O racleは、O racle Corp o ration 及びその子会社、関連会社の米国及びその他の国における登録商標です。 文中の社名、商品名等は各社の商標または

登録商標である場合があります。

Po stg reSQ Lは、PostgreSQ L Commu n ity Association o f Can ad aのカナダにおける登録商標およびその他の国における商標です。

W in d o w s は米国 Micro soft Co rporation の米国およびその他の国における登録商標です。

TPC, TPC B en ch mark, TPC-B, TPC-C, TPC-E, tp mC, TPC-H, TPC-DS, Q p h H は米国Tran saction Pro cessin g Performan ce Cou n cilの商標です。

その他、本資料に記載されている社名及び商品名はそれぞれ各社が 商標または登録商標として使用している場合があります 。

PostgreSQL Enterprise Consortium

Page 9 of 285

3. はじめにはじめに

3.1. PostgreSQLエンタープライズコンソーシアムとWG3について

Po stg reSQ Lエンタープライズコンソーシアム(略称 PG ECon s)は、Po stg reSQ L本体および各種ツールの情報収集と提供、整備などの活動を通じて、ミッションクリティカル

性の高いエンタープライズ領域へのPo stgreSQ Lの普及を推進することを目的として設立された団体です。

PG ECon s 技術部会ではPostgreSQ Lの普及に資する課題を活動テーマとし、3つのワーキンググループで具体的な活動を行っています。

W G1(新技術検証ワーキンググループ)

W G2(移行ワーキンググループ)

W G3(課題検討ワーキンググループ)

これら3つのワーキンググループのうち、W G1、W G 3については 2015 年度まではそれぞれ、「性能ワーキンググループ」、「設計運用ワーキンググループ」という名称で活動し

てきました。2016年度は、従来の活動領域を広げる意図のもとでそれらを再定義し、上記のような名称に改めました。

これに伴い、W G3ではPostgreSQ Lの設計運用を中心としたさまざまな課題の解決のための調査検証を行い、Postg reSQ Lが広く活用される事を推進していくこととしま

した。

3.2. 本資料の概要と目的

本資料はW G3の2017年度の活動としてPo stgreSQ Lにおけるレプリケーション機能について、調査検討した結果をまとめたものです。

これまでにも、W G3では3度にわたってレプリケーションについて取り上げています。

2013年では、PostgreSQ Lをエンタープライズ領域で活用するにあたって、業務要件とコストとのバランスを考えて可能な限り業務を継続できるように、システムの運用や保

守サービスをPostgreSQ Lで実現する手法についてまとめました [PG ECon s_W G 3_2013] 。報告書では、可用性を向上させるための手段としてレプリケーションを取り上

げています。今年度の報告書では取り上げなかった、ストレージレプリケーション(DRBD)、トリガベースレプリケーション(Slon y-I)についても紹介しています。

2014年度では、可用性のうち「災害対策」に焦点を当て、ITサービス継続を可能とする Po stgreSQ L の構成について調査検討しています [PG ECon s_W G3_2014] 。

ストリーミングレプリケーションを含む代表的な Po stgreSQ L のシステム構成を挙げて、データベースのデータ保全性、サービス継続性の観点から各構成の得失を示しまし

た。

2016年度では、ストリーミングレプリケーションの2ノードにおける運用ノウハウの整理や Postg reSQ L をベースとして双方向レプリケーションがリリースされています。

これらの開発動向と過去の検討結果とを踏まえて、2017年度は PostgreSQ L 10にて機能拡充が進むストリーミングレプリケーションの3ノードにおける運用ノウハウの整

理と、新機能のロジカルレプリケーションの調査を実施しました。

3.3. 本資料の構成

はじめに

Po stg reSQ Lにおけるレプリケーション

レプリケーションの目的

代表的なレプリケーションの手法

ストリーミングレプリケーション

はじめに

SR環境構築時の設定項目、推奨値

SR環境の監視

SR環境の障害時運用

スレーブのアーカイブ保存

まとめ

ロジカルレプリケーション(仮)

はじめに

ロジカルレプリケーション環境構築時の設定項目、推奨値

ロジカルレプリケーション動作検証

ロジカルレプリケーション性能検証

まとめ

B i-Directio n al Replication (B DR )

はじめに

B D R 環境構築時の設定項目、推奨値

B D R 動作検証

B D R 性能検証

まとめ

おわりに

3.4. 想定読者

PostgreSQL Enterprise Consortium

Page 10 of 285

本資料の読者は以下のような知識を有していることを想定しています。

DB M Sを操作してデータベースの構築、保守、運用を行うDB Aの知識

Po stg reSQ Lを利用する上での基礎的な知識

3.5. 参考文献

[PG E Co n s_W G 3_2013] Po stg reSQ L E n terprise Con sortium. 2013年度W G 3活動成果報告書. 2014. h ttps://w w w .pg eco n s.org/w p -

con ten t/u plo ads/PG E Co n s/2013/W G3/pg eco n s-w g3-2013-report.p d f

[PG E Co n s_W G 3_2014] Po stg reSQ L E n terprise Con sortium. 2014年度W G 3活動成果報告書 (可用性編). 2014. h ttps://w w w .pg eco n s.o rg /w p -

con ten t/u plo ads/PG E Co n s/2014/W G3/PG ECon s_2014_W G3_Availab ility.pdf

[Po stg resB D R ] 2n d Q u ad ran t. Po stg res-B D R. Version Po stg res-B DR94 1.0.2, Novemb er 14, 2016. h ttps://2n d qu adra n t.co m/en -

u s/reso u rces/bd r/

PostgreSQL Enterprise Consortium

Page 11 of 285

4. PostgreSQLにおけるレプリケーションにおけるレプリケーション

データベースにおいて、レプリケーションとは複数のデータベースサーバの間で、 何らかの一貫性を保ちながら、その内容を複製する手法を指します。Po stg reSQ Lにおいて

は、 9.0 以降の各バージョンの基本機能として、レプリケーションが実現されています。 また、PostgreSQ Lに付加するツールによってもレプリケーションが実現されています。

この章では、各種のレプリケーション機能を目的に応じて使い分けるために、機能と特性について簡単に紹介します。

4.1. レプリケーションの目的

レプリケーションによって複数のデータベースサーバの複製を作ることによって、シングルサーバでは対応が難しい要件にも対応できるようになります。それらは、データの冗長性

(複製があること)と複数サーバによる処理の分散の結果です。

4.1.1. 可用性の 向上可用性の向上

可用性はITシステムの非機能要件の一つで、システムを継続的に利用可能とすることです [IPA] 。 可用性は「継続性」「耐障害性」「災害対策」「回復性」という4つの

要素から構成されますが、レプリケーションによってデータベースサーバを冗長化することで、1つのサーバで故障や災害が生じたときにもレプリカが格納されている残りのサーバ

でサービスを継続することができるるようになります。また、運用上の停止が必要な場合であっても、各サーバを順次停止して作業することで、サービス全体としては停止させ

ないようにできます。

先に挙げた可用性の4つの要素をどの程度満足するかはデータベースの構成によって変わってきます。詳しくは『2013年度W G3活動成果報告書』

[PG E Co n s_W G 3_2013] を参考にしてください。

4.1.2. 性能向上性能向上

レプリケーションによって、同じ情報を格納しているデータベースサーバが複数存在することになります。それらのサーバでアプリケーションからの要求にこたえることが出来れ

ば、システム全体としての性能状況が期待できます(スケールアウト)。アプリケーションからの要求を複数のサーバに分散させる際には、更新(削除・挿入を含む)クエリを特定

の1サーバに集約する「シングルマスタ」構成と、複数のサーバに分散する「マルチマスタ」構成があります。また、参照クエリを複数のサーバに分散させることを参照負荷分散

と呼びます。

レプリケーションクラスタを性能向上に用いる場合、複数のデータをベースを同時に運用することから生じる特有の課題があります。レプリケーション方式を選択する際には、

それらの課題をどの程度解決しているのかについても考慮する必要があります。

4.1.2.1. 参照の同期参照の同期

ある瞬間に同一の参照クエリを異なるサーバに送った時に、まったく同じ結果が返ってくるものと、そうでないものとがあります。同じ結果が得られる場合、サーバは同期してい

る、同期レプリケーションであると言います。

4.1.2.2. 更新による一貫性の 維持更新による一貫性の維 持

マルチマスタ構成の場合には同期の問題に加えて、更新の衝突と一貫性の維持が問題となります。

更新の衝突

複数のアプリケーションプログラムから同一の更新操作を実行しようとした場合、単一のDB サーバであればどちらかの操作が遅延され、場合によってはエラーとなり

ます。マルチマスタ構成では、レプリケーションの送信側でなされた更新と、そのサーバに直接要求された更新とが衝突した場合に、どちらが優先するのかが問題と

なります。

一貫性の維持

更新が衝突した結果、レプリケーションの送信側と受信側でデータベースの内容が異なってしまうと、レプリケーションによって構成されるクラスタ全体でデータベース

の一貫性が維持されなくなります。この問題を適切に対処する必要があります。

4.2. 代表的なレプリケーションの手法

ここでは、本報告書で取り上げるレプリケーション手法を中心に、PostgreSQ L で利用できる代表的なレプリケーション手法を紹介します。レプリケーションを利用する立場

からは、シングルマスタとマルチマスタに二分することができます。その上で、レプリカを生成する方法に着目して代表例を挙げ、そのメリット・デメリットを説明します。

なお、『2013年度W G3活動成果報告書』 [PG ECon s_W G 3_2013] では可用性向上の観点から、レプリケーションを含めて様々な Po stgreSQ L の構成を取り上げて

いますので、併せてご覧ください。

コミュニティのW ikiページには、Po stg reSQ L上で動作するクラスタソフトウェアについての解説があり、その中にレプリケーションも含まれています [PGW iki_replica] 。ここで

紹介する紹介するレプリケーションソフトウェアについても紹介されています。

4.2.1. シ ン グルマ スタシン グルマスタ

シングルマスタ構成の場合、レプリカを生成する手法には以下のようなものがあります。

ストレージレプリケーション

トリガベースレプリケーション

クエリベースレプリケーション

ストリーミングレプリケーション

PostgreSQL Enterprise Consortium

Page 12 of 285

ロジカルレプリケーション

4.2.1.1. スト レージレプリケ ーショ ンスト レージレプリケ ーショ ン

Po stg reSQ Lやその上で動作するツールを介することなく、データを格納するストレージのレベルでデータを複製します。ストレージ装置自体がレプリカを生成するものや、

DRB D [DRB D ] のようにLin u x上で動作するソフトウェアによる実現があります。

メリット

Po stg reSQ Lからは単一のサーバに見えるので、単一サーバと同じように運用できます

デメリット

受信側のサーバはデータベースとしては動作していないので、負荷分散に利用することができません

4.2.1.2. トリガ ベ ースレプリケ ーショ ントリガ ベースレプリケ ーショ ン

Po stg reSQ Lのデータベース内に更新によって起動されるトリガを設定しておき、更新による変分を受信側のサーバに送り出すもの。代表的な製品に Slony-I があります。

以下では Slo n y-I での主なメリット・デメリットを紹介します。

メリット

Po stg reSQ Lのデータベースクラスタに含まれる表全体だけでなく、任意のテーブルについてだけ複製を作成することができる

更新される表については参照負荷分散、それ以外の表については更新負荷分散が可能です

デメリット

比較的オーバヘッドが大きいため、後述のストリーミングレプリケーション方式に比べて、性能が低い傾向があります [pg logical]

4.2.1.3. ク エリベースレプリケ ーショ ンク エリベースレプリケ ー ショ ン

アプリケーションプログラムとD B サーバ(Po stgreSQ L)の間に入るミドルウェアによって、発行されたクエリを複製して複数のDB サーバに送信することで、データベースを複製し

ます。代表的な製品に Pg p o o l-II [Pg p oo l-II] があります。

メリット

複数のD B サーバを用いて負荷分散を実現する際に、参照クエリ・更新クエリともに適切なサーバにクエリが自動的に振り分けられるため、アプリケーショ

ンから見ると単一のDB サーバを利用しているように見える

デメリット

一部のSQ L文に対する挙動が単一のDB サーバとは異なる

4.2.1.4. スト リー ミ ングレプリケ ーショ ンスト リーミ ングレプリケ ー ショ ン

Po stg reSQ L データベースでは、更新をコミットした際にその結果をクラッシュ等で失わないように更新情報をファイルに書きこむログ先行書込み(W rite Ah ead Logg ing ;

W AL)を用いています。このW ALファイルにはデータベースに対する更新を全て復元することができる情報が含まれていますから、これを他のDB サーバに転送することでデータ

ベースを複製することができる --- これがストリーミングレプリケーションの基本的な考え方です。

ストリーミングレプリケーションは、W ALファイルに書かれた内容をほぼそのまま受信側(スレーブサーバ)に送り出すことで、送信側(マスタサーバ)と物理的に一致するD B を複製

します。

メリット

受信側サーバに送信側サーバと物理的に一致したデータベースを複製することができる

送信側サーバでコミット済みのデータを受信側で確実に書き込み済みにすることができるため、高信頼化に適している

参照負荷分散ができる

デメリット

特定のデータベース、表だけを複製することはできない

メジャーバージョンが異なるPo stgreSQ Lの間では利用できない

受信側サーバのデータベースは更新できない

4.2.1.5. ロジカ ルレプリケーショ ンロジカルレプリケ ーショ ン

ロジカルレプリケーションは、PostgreSQ Lバージョン10から標準採用された機能です。ストリーミングレプリケーションが送信側のW ALをそのまま受信側に転送するのに対し

て、ロジカルレプリケーションは送信側でW ALファイルをデコードし、必要な変更内容のみを受信側に送ります。

メリット

送信側サーバの一部の表に対する更新だけを受信側に送ることができる

複数の送信側サーバの出力を1つの受信側サーバで受け取ることができる

PostgreSQL Enterprise Consortium

Page 13 of 285

メジャーバージョンが異なるPo stgreSQ Lの間でも利用できる

受信側サーバのデータベースを更新することができる

デメリット

レプリケーションできないSQ Lやオブジェクトがあり、送信側と受信側で不整合が発生しないよう注意して運用する必要がある

受信側サーバのデータベースを更新した場合、送信側サーバでの更新内容と競合する可能性がある

4.2.2. マ ルチマスタマル チマスタ

マルチマスタ構成の場合、レプリカを生成する手法には以下のようなものがあります。

B i-Directio n al Replication

B u card o

4.2.2.1. Bi-Directional Replication

2n d Q u adran t社が公開している B i-D irection al Replication は、先に紹介した論理レプリケーションを用いてデータを複製しつつ、複数のサーバでデータの更新を可

能としたものです。主な用途としては地理的に離れた場所にある複数のサーバ間で、データを共有する利用形態を想定しています [Po stg resB D R ] 。

メリット

論理レプリケーションを利用しているため、他の方式によるマルチマスタに比べてオーバヘッドが小さい

デメリット

レプリケーション自体は非同期に行われるため、複数サーバに同時に発行した参照クエリの結果が異なることがあります。

4.2.2.2. Bucardo

B u card o は、トリガベースレプリケーションを使ってデータを複製します [B u card o ] 。そのため、メリット、デメリットはシングルマスタのトリガベースレプリケーションと同じです。

4.3. 参考文献

[IPA] 独立行政法人情報処理推進機構. 非機能要求グレード 利用ガイド[活用編]. 2010. h ttp://w w w .ip a.go.jp/files/000026853.p df

[PG W ik i_rep lica] Smith , G .; Grittn er, K.; Pin o , Con rad T.; R ing er, C.; Simon , R . et al. R ep licatio n , Clusterin g , a n d Co n n ectio n Pooling . 2017.

h ttps://w iki.postgresql.org /w iki/R eplication ,_Clu sterin g ,_an d _Con n ectio n _Po oling

[DRB D] LINB IT, In c. h ttp://w w w .d rbd.org /en/

[p g lo g ical] 2n d Q u adra n t. pg logical. h ttps://2n d qu adran t.co m/en/resou rces/pg logical/

[Pg p oo l-II] Pg Po o l G lobal Develop men t G rou p . h ttp://w w w .p g po ol.n et/med iaw ik i/in d ex.ph p /M ain _Page

[B u cardo ] Jensen, G .; Sabin o, G . M . et al. h ttps://b u cardo .o rg/w iki/Main _Page

PostgreSQL Enterprise Consortium

Page 14 of 285

5. ストリーミングレプリケーションストリーミングレプリケーション

5.1. はじめに

5.1.1. PostgreSQLの ストリー ミン グレプリ ケーシ ョ ンの特徴のストリー ミングレプリケーシ ョ ン の特徴

Po stg reSQ Lのストリーミングレプリケーション(以下、SR構成)は以下を目的とした構成です。

可用性の向上

性能向上

以下の特徴があります。

変更履歴が格納されたW ALを操作単位でマスタ側からスレーブ側へ転送することでデータを同期

SR基本構成図(スレーブ1台)

Po stg reSQ L 10 における主な機能を示します。

完全同期方式完全同期方式 により、スレーブ活用度の向上が期待できる

同期式はW ALの転送までの保証であり、データ保護が目的。

完全同期式はW ALの適用までの保証であり、データ同期が保証されるため、リアルタイムのデータ参照に期待。

syn ch ro n o u s_co mmitには以下の設定が可能であり、要件に応じて選択。

remote_apply :完全同期。W AL適用まで保証。昇格時の時間短縮と参照負荷分散の拡充が目的。

on :同期。W AL転送(ディスク書き込み)まで保証。データ保護が目的。

remote_w rite :準同期。W AL転送(メモリ書き込み)まで保証。データ保護とパフォーマンスのバランスが目的。

lo ca l :非同期。ローカルのW AL書き込みまで保証。パフォーマンス優先が目的。

off :完全非同期。ローカルのW AL書き込みすら保証しない。最も高パフォーマンスだが非現実的。

以下の図はsyn ch ro n o u s_co mmitの設定による保証時点を示す。

レプリケ ー ショ ンスロットレプリケ ー ショ ンスロット により、スレーブに必要なW ALをマスタが確保し続ける

スレーブの障害時(ネットワーク不調含む)等にマスタでW ALを保持し切れず、W ALファイルの再利用によりロストする懸念がある。

レプリケーションスロットの登場前はw al_keep _segmen tsパラメータによる調整、またはアーカイブモード運用が必要であった - w al_keep_seg men ts

はW AL数を指定するものであるため、見積もりが困難である。 - アーカイブモードも複数スレーブ構成における不要W ALファイルの判断はやはり困難。

レプリケーションスロットによりW ALファイルの要・不要の判断をシステムに任せる事ができる。

SR構成のW ALファイル管理のためにアーカイブモード運用は必要はなく、過去の時点に復旧する(PITR )要件がある場合に設定する。

PostgreSQL Enterprise Consortium

Page 15 of 285

複数スレーブの場合は、スレーブ毎に専用のレプリケーションスロットを作成する。

複数同期スレーブ構 成複数同期スレーブ構 成 が可能

従来も複数スレーブ構成は可能であったが、同期スレーブはその内の1台までという制限があったがそれが取り払われた。

同期スレーブを任意(ANY)に選択するQ uo rum-based 同期レプリケーションが実装された。

遅延レプリケーショ ン機能遅延レプリケーショ ン機能 により、オペレーションミスを反映させない事が可能に

スレーブでの適用を一定時間待機する機能である。マスタでのオペミスが即座にスレーブに伝搬されるのを防ぐのが主な目的。

W ALファイルの転送は遅延なく処理されるため、データ保全(RPO )の観点では問題ない。同期モードで設定する事もできる。

recovery.con f のreco very_min _apply_delayパラメータに遅延時間を設定。

従来からの手法として、PITRを使用してオペミス直前時点を指定してリカバリすることで障害回復を図る方法もある。

巻き戻し機能巻き戻し機 能 (p g_rew ind )により、効率の良いSR 再構成が可能に

旧マスタを分岐時点へ巻き戻す事で、新マスタに追い付く事が可能な状態とする機能である。

巻き戻し後、旧マスタに新マスタのW ALを適用(追い付き)する事で旧マスタを新スレーブとして構成。

従来はpg_baseb acku p 等による再作成が必要であった。

大規模データベースでは、大幅な時間短縮が期待できる。

下図に巻き戻し機能のイメージを示す。

PostgreSQL Enterprise Consortium

Page 16 of 285

WAL圧縮機能圧縮機能 により、W AL転送の効率を改善

W AL圧縮でサイズを縮小することにより、W AL転送の効率改善が目的。

スレーブを遠隔地に配置する場合に特に有効。

注意点としては、圧縮(マスタ)や解凍(スレーブ)の負荷が発生する。

SR構成の運用上の注意点

死活監視と障害発生時のフェイルオーバはPo stgreSQ Lの機能ではできないため、クラスタソフトを利用する必要があります。 商用クラスタソフトが使用される場

合もありますが、オープンソースソフトウェアのPgpo o l-II と呼ばれるクラスタソフトを使用した例も多く報告されています。 特に参照負荷分散を行う場合は、

Pgp oo l-IIを使用します。

5.1.2. 検証を実施した検証を実施したSR構成構成

以下のSR構成にて検証を実施しています。

対象バージョンは Po stgreSQ L 10

2017年11月 時点の最新版

3ノード構成

1. 複数スレーブ方式(親 - 子1 , 子2) スレーブ2はマスタと繋がっている。

2. カスケード方式(親 - 子 - 孫) スレーブ2はスレーブ1と繋がっている

Po stg reSQ Lの機能に限定

Pgp oo l-II等のクラスタソフトに関するテーマは対象外

PostgreSQL Enterprise Consortium

Page 17 of 285

5.2. SR環境構築時の設定項目、推奨値

5.2.1. SRにお け る目的別の設定における目的別の設定

Po stg reSQ LのSR構成には様々な機能があり、 対処する障害に応じて適切に設定する必要があります。 また各機能は組み合わせることが可能です。

"ストリーミングレプリケーション"を"SR"と表記します。

"レプリケーションスロット"を"スロット"と表記します。

表 5.1 SRの機能

機能機能 内容・ 目 的内容・ 目 的 注意点・ 補足注意点・ 補足

アーカイブW AL

必要なW ALファイルの保持。以下の2種類。

物理バックアップ(PITR )に必要な(フルバックアップ以降

の)W AL。 障害発生直前まで復旧や操作ミス時に過去

に戻す機能がある。

SR構成において未転送のW ALを保持する。

アーカイブW ALがディスク領域を圧迫しないように、不要となった

アーカイブW ALの明示的な削除が必要。

SR用途の場合、W ALファイルの要不要の判断が困難であるた

め、現在では後述のレプリケーションスロットの使用が一般的。

SR構成には物理バックアップという側面もあるため、過去に戻す

要件がなければ物理バックアップを取得する必要性は低い。

これらを考慮し、一般的には非アーカイブモード運用でも十分と

考えられる。

レプリケーションスロッ

ト

スレーブに必要なW ALファイルを保持する事によるSR構成の維持。

対応する各スレーブの未転送のW ALを保持する。

スレーブへW ALファイルの転送ができない状態が続くと、W ALファ

イルが溜まり領域を圧迫する。

複数スレーブ構成では、スレーブ毎にスロットの使用/未使用を

選択できる。

スレーブ毎にスロットを作成する必要がある。

遅延レプリケーション スレーブ側のW AL適用を意図して遅らせることで、スレーブを一定

の過去の状態に維持する。 操作ミス対策に任意の時点まで巻き

戻せるようにする。

スレーブは常に過去の状態であるため、参照活用には一定の制

限がある。

フェイルオーバ時には遅延分の適用が必要になるため、RTO の

点で難がある。そのため複数スレーブ構成の場合に1スレーブで

構成するのが一般的。

W AL圧縮 Fu ll Page W rite時(チェックポイント後の最初の更新時)に、W AL

ファイルに書き出すフルページイメージを圧縮する。 圧縮された

W ALは適用時に解凍される。 W ALサイズを大幅に圧縮できる可

能性があり、転送負荷の低減が期待される。特にディザスタ・リカバ

リ構成で有効と考えられる。

マスタの圧縮時とスレーブの解凍時に通常より余分にCPU 負荷

と時間がかる。

5.2.2. SRの基本設定手順(の基本設定手順( 2ノ ード)ノー ド)

基本的なSR 環境の設定手順を紹介します。 尚、マスタとスレーブの両サーバにPo stg reSQ Lはインストール済みであり、 マスタ側ではデータベースクラスタを構築しているこ

とを前提としています。

1. 関連パラメータ

SR構成に最低限必要な設定は以下の通りです。 スレーブはマスタのベースバックアップから作成されるため、マスタに設定したパラメータは全てスレーブも

同様の値に設定されます。

"ストリーミングレプリケーション"を"SR"と表記します。

"レプリケーションスロット"を"スロット"と表記します。

説明の便宜上、以下の設定とします。

表 5.2 構成データ

項目項目 内容内容

マスタのIPアドレス およびサーバ名 192.168.100.101/24 server1

スレーブのIPアドレスおよびサーバ名 192.168.100.102/24 server2

ポート番号 5432

レプリケーション用ユーザ/パスワード repu ser/passw ord

PostgreSQL Enterprise Consortium

Page 18 of 285

表 5.3 SR構成の設定(マスタのp g_h b a.co n f)

設定値設定値 内容内容

h ost replication repu ser 192.168.100.101/32 tru st

h ost replication repu ser 192.168.100.102/32 tru st

またはCIDR指定にて

h ost replication repu ser 192.168.102.0/24 trust

SR用ユーザの接続を許可する。

・pg _h b a.con fは両ノード共通の設定となる事から、

どちらがマスタになっても使用できる設定とする。

・IPアドレスはW AL転送を行うネットワークLANを指定。

パブリックLAN以外に、ハートビート系LANも有力。

・認証方式は任意だが、passw ord やmd 5ではパスワードファイルにより入力を求

められないようにする。

表 5.4 SRの設定(マスタのpo stg resq l.con f)

パラメ ータパラメ ータ 設定値設定値 内容内容

listen _add resses '0.0.0.0' 接続を受け入れるIPを指定。

再起動で反映。

w al_level replica W ALに書かれる情報量を指定。

SR構成の場合は rep lica に設定。

デフォルトがrep licaであるため変更不要。

再起動で反映。

w al_keep_segmen ts 64 暫定値として、ma x_w al_size/16MBの値を設定。

スロットを使用する場合は設定不要。

リロードで反映。

syn ch ro n o u s_co mmit on 目的に応じて設定する。

remote_apply : 完全同期。W AL適用までを保証。

on : 同期。W AL転送後のディスクへの書き込みまで保証。

remote_w rite : 準同期。W AL転送後のメモリ書き込みまで保証。

lo ca l : 非同期。ローカルへの書き込みまで保証(リモートは保証しない)。

off : 完全非同期。ローカルへの書き込みも保証しない。

同期式におけるスレーブ障害時および復旧時の同期/非同期の切り替えは

syn ch ro n o u s_stan d b y_n amesにて行う。本パラメータは固定。

リロードで反映。

syn ch ro n o u s_stan d b y_n ames ''(非同期) SRの非同期と同期を切り替えに使用。

非同期の場合 : ''

同期の場合 : '*' あるいは特定スレーブのapp licatio n _n ame

リロードで反映。

max_w al_send ers 10 起動するw al sen ders数を指定。

pg _b aseb acku pでW ALストリーミングを指定する場合はその分も考慮

通常はデフォルトの10で問題ない。

再起動で反映。

max_replication _slot 10 レプリケーションスロットを作成可能な最大数

通常はデフォルトの10で問題ない。

再起動で反映。

restart_after_crash off on の場合、インスタンス障害(po stg resプロセスは残存)の場合に、自動的に再起動を行

う。

シングル構成では便利な機能であるが、SR構成では管理が複雑化するため、offに設定

するのが一般的。

リロードで反映。

PostgreSQL Enterprise Consortium

Page 19 of 285

表 5.5 SRの設定(スレーブのpo stg resql.con f)

パラメ ータパラメ ータ 設定 値設定値 内容内容

h ot_stan db y on ホットスタンバイとして参照可能な状態で起動する。

スレーブに対しても監視SQ Lを実行できるように通常は有効化する。

デフォルトでon であるため、変更は不要。

h ot_stan db y_feedback on o n の場合、スレーブが現在処理している問い合わせについて、マスタへフィー

ドバックを送る。

通常は有効化する。特にスロットを作成する場合には有効化が必須。

デフォルトはoffであるため、変更が必要。

表 5.6 SRの設定(スレーブのrecovery.co n f)

パラメ ータパラメ ータ 設定 値設定値 内容内容

stand b y_mode on スレーブとして起動か、PITRのリカバリ処理かを区別をする設定。

on の場合は、スレーブとして起動する。W ALファイルの最後に達してもリカバリ

を終了せず、マスタへ接続して新W ALセグメント取得を継続。

primary_co n n info 'h o st=server1 po rt= 5432

u ser= repu ser

passw ord = p assw ord

applicatio n _n ame=server2'

マスタへの接続文字列を指定。

h ostはW AL転送を行うLANを指定。2サーバ間の転送のみである事から、

ハートビートLANでも良い。

po rtはPo stg reSQ Lがリスニングしているポート番号(p o rtパラメータ)。

u serはreplication 仮想データベースへ接続できるユーザを指定(ユーザの

replica tion 属性およびpg _h b a.con fの設定)。

passw ord はパスワードが必要な場合に設定。パスワードの記載を避けたい

場合は、~ /.pgpassを使用。

applicatio n _n ameは視認性を高めるのが目的であり必須ではない。ここで

はスレーブ名を指定。

デフォルトで'w al_receiver'。

recovery_targ et_timelin e latest リカバリが作成する個別のタイムラインを指定。

SR構成ではlatestを指定して最新タイムラインを追従。

primary_slot_n ame <スロット名> 当該スレーブ用のスロットを作成している場合は、スロット名を設定。

最新バージョンではスロットを作成するのが一般的。

restore_co mman d アーカイブW ALファイルのリストア(コ

ピー)方法を指定

スロットを使用している場合は設定不要

2. 構築手順

ここでは基本的な2ノード構成における手順を記載します。

表 5.7 SR構成条件

項目項目 内容内容

同期方式 非同期(syn ch ro n o u s_stan d b y_n ames = '')

レプリケーションスロット 使用しない

(1)レプリケーションユーザ作成

マスタサーバでレプリケーション用のユーザを作成します。

postgres=# CREATE ROLE repuser LOGIN REPLICATION PASSWORD 'password';

(2)設定ファイルの変更

マスタで$PGDATA配下のp g_h b a.co n fとpo stg resql.con fを変更します。

pg _h b a.con f

PostgreSQL Enterprise Consortium

Page 20 of 285

レプリケーションユーザがデータベース接続できるようpg _h ba.co n fを次のように設定します。 ここでは便宜上、trust認証を

指定しています。 md5認証を指定する場合はパスワードファイル(~ /.p g p ass)を使用して、パスワードの入力が不要となるよ

うに設定します。

$ vi $PGDATA/pg_hba.conf

[pg_hba.conf]

# デフォルトで以下の設定が登録されています。

local replication all trust

host replication all 127.0.0.1/32 trust

host replication all ::1/128 trust

# 以下の様に変更します。

host replication repuser 192.168.100.100/32 trust

host replication repuser 192.168.100.101/32 trust

host replication repuser 192.168.100.102/32 trust

po stg resq l.con f

マスタとして稼働させるため、po stgresq l.con fを次のように設定します。 スレーブ側の設定も含めておきます。スレーブ側の

設定は、マスタ側では無視されます。

$ vi $PGDATA/postgresql.conf

[postgresql.conf]

port = 5432 (デフォルト)

listen_addresses = '*'

wal_level = replica (デフォルト)

synchronous_commit = on (デフォルト)

synchronous_standby_names = '' (デフォルト)

max_wal_senders = 10 (デフォルト)

max_replication_slots = 10 (デフォルト)

restart_after_crash = off

hot_standby = on (デフォルト)

hot_standby_feedback = on

パラメータの記述後、設定ファイルの変更を反映するためにPostg reSQ Lを再起動します。

$ pg_ctl restart

(3)pg_basebacku p による物理ファイルのコピー (スレーブ)

スレーブ側でpg_baseb acku p を実行し、スレーブデータベースを構築します。

$ pg_basebackup -h <マスタIP> -p 5432 -U repuser -D $PGDATA --progress --

verbose

なおパスワードファイルはpg_baseb acku p ではコピーされないため、必要に応じてコピーします。

$ scp <マスタIP>:~/.pgpass ~/

(4)reco very.con fの設定(スレーブ)

pg _b aseb acku pで取得したデータベースクラスタの設定を変更し、スレーブとして稼働するようにします。 取得先($PGDATA)配下

でrecovery.con fを作成します。 なおスレーブに必要なパラメータ設定は(po stg resql.con f)は、マスタ側で設定済みのファイルがコ

ピーされているため、変更不要です。

PostgreSQL Enterprise Consortium

Page 21 of 285

recovery.con f

$PG D ATA配下にreco very.con fを作成し、以下を記述します。

$ vi $PGDATA/recovery.conf

[recovery.conf]

standby_mode = 'on'

primary_conninfo = 'host=server1 port=5432 user=repuser

password=repuser'

recovery_target_timeline = latest

(5)Po stgreSQ Lの起動(スレーブ)

スレーブのPostgreSQ Lを起動します。

$ pg_ctl start

(6)状況確認(マスタ)

SRが構築されていることを確認します。

[マスタ側で確認]

postgres=# \x

Expanded display is on.

postgres=# SELECT * FROM pg_stat_replication;

-[ RECORD 1 ]----+------------------------------

pid | 40724

usesysid | 16385

usename | repuser

application_name | walreceiver

client_addr | <スレーブのIP>

client_hostname |

client_port | 48077

backend_start | 2018-01-04 01:30:54.01041+09

backend_xmin |

state | streaming

sent_lsn | 0/3000060

write_lsn | 0/3000060

flush_lsn | 0/3000060

replay_lsn | 0/3000060

write_lag |

flush_lag |

replay_lag |

sync_priority | 0

sync_state | async

(7)状況確認(スレーブ)

PostgreSQL Enterprise Consortium

Page 22 of 285

[スレーブ側で確認]

postgres=# \x

Expanded display is on.

postgres=# SELECT * FROM pg_stat_wal_receiver;

-[ RECORD 1 ]---------+--------------------------------------------------

pid | 52484

status | streaming

receive_start_lsn | 0/3000000

receive_start_tli | 1

received_lsn | 0/3000140

received_tli | 1

last_msg_send_time | 2018-01-04 01:35:50.514256+09

last_msg_receipt_time | 2018-01-04 01:18:46.923761+09

latest_end_lsn | 0/3000140

latest_end_time | 2018-01-04 01:33:20.23195+09

slot_name |

conninfo | user=repuser password=******** dbname=replication

host=<マスタのIP> port=<マスタのポート番号>

fallback_application_name=walreceiver

sslmode=disable sslcompression=1

target_session_attrs=any

con n in fo 列は実際には1行で表示されますが、便宜上改行しています。

5.2.3. スレーブ の追加スレーブの 追加

2ノード構成からスレーブ(server3)を追加する方法は、基本的には前述の手順と同様です。 複数スレーブ方式とカスケード方式の違いはserver3側でpg_baseb ack u p

を実行するのは同様で、マスタの指定の違いだけです。 カスケード方式では、マスタに負荷をかけないというメリットがあります。

1. pg _b aseb acku pの実行(server3)

(複数スレーブ構成:マスタはsever1)

$ pg_basebackup -h server1 -p 5432 -U repuser -D $PGDATA --progress --

verbose

(カスケード構成 :マスタはserver2)

$ pg_basebackup -h server2 -p 5432 -U repuser -D $PGDATA --progress --

verbose

2. recovery.con fの設定(server3)

recovery.con f

$PG D ATA配下にreco very.con fを作成します。 カスケード方式の場合にはserver2からコピーされたファイルが存在する

ので、それを修正します。 server2の設定とほぼ同様で、異なるのはマスタの指定です。

$ vi $PGDATA/recovery.conf

[recovery.conf]

(複数スレーブ構成:マスタはsever1)

primary_conninfo = 'host=server1 port=5432 user=repuser

password=repuser'

(カスケード構成 :マスタはserver2)

primary_conninfo = 'host=server1 port=5432 user=repuser

password=repuser'

5.2.4. ア ーカイブモード運用アー カイブモード運用

SR構成においてもアーカイブモード運用は有力です。 スレーブが物理バックアップとも言えますのでアーカイブモード運用は必須ではありませんが、以下を目的として構成する

事もあります。

PostgreSQL Enterprise Consortium

Page 23 of 285

・ PITR (Po in t In Time Recovery)にて一定の過去に戻す

アーカイブモード運用の最大のメリットと言えます。

類似機能として「遅延レプリケーション」もありますが、PITRの方がより汎用的です。

・アーカイブW ALの保持

フルバックアップを1日1回取得する場合、アーカイブW ALも1日分(あるいはそれ以上)保持することになります。

SRの伝搬の遅れが保持時間以内に収まっていれば、SRを継続できます。

W ALを保持する機能としては、レプリケーションスロットがあります。

SRを意識してW ALを確保するため、必要なW ALが欠落するリスクはありません。

ただし伝搬遅延が大きくなりすぎた場合、W AL領域がディスクフルになるリスクがあります。

アーカイブモード運用の場合は定期的に削除するため、そのリスクは低いと言えます。

1. 関連パラメータ

既存のレプリケーションスロットの設定に加え、次のパラメータを指定します。

サーバサーバ 設定ファイル設定 ファイ ル パラ メ ータパラ メ ータ 設定値設定値 内容内容

マスタ po stg resq l.con f arch ive_mode o n アーカイブを有効化する。

マスタ po stg resq l.con f arch ive_co mman d cp %p <アーカイブの保存先>/% f アーカイブの実行コマンドを指定する。 スクリ

プトを指定する事も可能であるため、複雑な

処理を組み込む事が可能。

スレー

ブ

recovery.con f restore_co mman d 'scp <マスタのユーザ名> @ <マスタのホスト

名> :< マスタのアーカイブ・ディレクトリ> % f

%p'

マスタのアーカイブを取得するコマンドを指定

する。 W AL同期を保証する場合に必要とな

る。ただしレプリケーションスロットを使用する

場合は不要である。

注釈

restore_co mman d にてscpコマンドを使用する場合、スレーブはマスタのPo stgreSQ LのO Sユーザに ssh にてパスワードなしで接続できるよう

になる必要があります。 またはアーカイブ・ディレクトリをNFSマウント等、マスタ/スレーブ間で共有可能なパスにする事で、 アーカイブの扱いが容

易になります。

障害時スレーブをマスタにする場合に備え、マスタに設定したパラメータは スレーブ側でも事前に有効化することを推奨します。

2. 設定手順

(1)マスタ側のp ostg resql.con fのパラメータを以下のように設定する。

$ vi $PGDATA/postgresql.conf

[postgresql.conf]

archive_mode = on

archive_command = 'cp %p <アーカイブの保存先>/%f'

(2)必要ならばスレーブ側のrecovery.con fのパラメータに以下を追加する。

$ vi $PGDATA/recovery.conf

[recovery.conf]

restore_command = 'scp <マスタのユーザ名>@<マスタのホスト名>:<マスタのアーカイブ・ディレクトリ>%f %p'

(3)マスタ側を再起動し、その後スレーブ側を再起動する。

[マスタ/スレーブの両方で実施]

$ pg_ctl restart

(4)マスタ側で強制的にW ALファイルを切り替え、アーカイブW ALファイルが出力されることを確認する。

PostgreSQL Enterprise Consortium

Page 24 of 285

postgres=# SELECT pg_switch_xlog();

pg_switch_xlog

----------------

0/7017008

(1 row)

$ <アーカイブ・ディレクトリ>

000000010000000000000007

5.2.5. レ プリ ケーシ ョンスロットレプリケーシ ョ ン スロッ ト

スレーブに未転送のW ALを保持することで、SRの維持を保証します。 アーカイブ運用でも同期の保証は可能ですが、アーカイブログの管理などが問題となり、 ノーアーカイ

ブ運用をしている環境も多くあります。 そのような環境において、レプリケーションの維持を保証するためには、レプリケーションスロットの設定が必要です。 またアーカイブ運用

においても、アーカイブW ALファイルの削除にSRの考慮が不要になるため、有用な設定です。

1. 関連パラメータ

既存のレプリケーションスロットの設定に加え、次のパラメータを指定します。

基本的なSR の構築手順にて設定済みのパラメータも、改めて記載しています。

表 5.8 レプリケーションスロットの設定

サーバサーバ 設定ファイル設定ファイル パラメ ータパラメ ータ 設定値設定値 内容内容

マスタ po stg resq l.con f max_replication _slots スレーブ数以上(設定済み) 作成可能なレプリケーションスロット数を指

定する。

スレー

ブ

po stg resq l.con f h o t_stan d b y_feedback o n (設定済み) スレーブの状態をマスタにフィードバックす

る。

スレー

ブ

recovery.con f primary_slot_n ame レプリケーションスロット名 使用するレプリケーションスロット名を指定

する。

注釈

障害時スレーブをマスタにする場合に備え、マスタに設定したパラメータは スレーブ側でも事前に有効化することを推奨します。

2. レプリケーションスロットの作成方法

レプリケーションスロットに関連する関数は以下の通りです。

表 5.9 レプリケーションスロットの関数

関数名関数名 説明説明

pg _create_p h ysical_replicatio n _slot(スロット名[,

tru e/false])

レプリケーションスロットを作成する。

スロット名:作成するレプリケーションスロット名を指定する。

tru e/false:tru eの場合、レプリケーションスロットは即座にW ALを保持する。

falseの場合従来通り、スレーブがレプリケーションスロットに繋いだ時点から

W ALを保持する。

pg _d rop_replication _slot(スロット名)

レプリケーションスロットを削除する。

スロット名:削除するレプリケーションスロット名を指定する。

3. 検証

(1)マスタにてpo stg resql.con fにmax_replication _slotsを加え、設定反映のため再起動。

$ vi $PGDATA/postgresql.conf

[postgresql.conf]

max_replication_slots = 10 <--- デフォルト

$ pg_ctl restart

PostgreSQL Enterprise Consortium

Page 25 of 285

(2)マスタにてレプリケーションスロットを作成。

postgres=# SELECT pg_create_physical_replication_slot('slot1', true);

pg_create_physical_replication_slot

-------------------------------------

(slot1,0/B000220)

(1 row)

(3)マスタにてレプリケーションスロットの作成を確認。

postgres=# SELECT slot_name, restart_lsn, active FROM pg_replication_slots;

slot_name | restart_lsn | active

-----------+-------------+--------

slot1 | 0/B000220 | f

(1 row)

・active列が'f'であることから、まだ使用されていない。

・restart_lsn列に値があることから、使用されていなくてもW ALの保持は開始している。

(4)スレーブにてreco very.co n fにp rimary_slot_n ameを加え、設定反映のため再起動。

$ vi $PGDATA/postgresql.conf

[recovery.conf]

primary_slot_name = 'slot1'

$ pg_ctl restart

(5)マスタ側でレプリケーションスロットが使用されていることを確認。

postgres=# SELECT slot_name, restart_lsn, active FROM pg_replication_slots;

slot_name | restart_lsn | active

-----------+-------------+--------

slot1 | 0/B0002C8 | t

(1 row)

・active列が't'であることから、使用されている。

5.2.6. 【 参考情報】 同期モー ドにおけ るパフォ ーマンスへの 影響【参考情報】同期モー ドにおけるパ フォ ー マン スへの 影響

同期モードの懸念として、W AL転送の待機によるパフォーマンスへの影響があります。 以下の図はsyn ch ro n o u s_co mmitの各設定によるパフォーマンス比較です。(on の

値を1.00とした相対値)。

サーバススペック

CPU : In tel(R ) Xeon (R ) CPU E5-2640 v2 @ 2.00GHz 16Core

メモリ : 64GB

O S : Red Hat En terp rise Lin u x Server release 6.5 (Santiago)

Po stg reSQ Lのバージョン : Po stg reSQ L 9.6.1

パラメータ設定

キャッシュヒット率の影響を受けないようほぼ100%となるように調整

shared_bu ffers : 8G B

処理中に自動VACUUM が発生しないように無効化

au tova cu u m :off

処理中にチェックポイントが発生しないように調整

ch eck p o int_timeou t :1h

max_w al_size :10G B

処理前に毎回手動でチェックポイント実行

トランザクションツールはpgben ch を使用。

初期化スケール 100

100セッション、25ワーカスレッドのトランザクションを実施(p g ben ch -c 100 -j 25)

PostgreSQL Enterprise Consortium

Page 26 of 285

通常のO LTPアプリケーションではこれほど激しいトランザクションではないため、低下は限定的と考えられます。

同期モードの実装にあたっては、実際のアプリケーションで検証してご確認ください。

5.2.7. 遅延レプ リケーショ ン遅延レプリケーション

スレーブの適用を一時的に遅延させます。 マスタの操作ミスが即座に伝搬されるのを防ぐのが目的です。 W AL転送までは遅延なく処理されるため、データ保全には影響

ありません。 同期転送(syn ch rono u s_co mmit=o n )との組み合わせができます。

注意点

・マスタへの切り替わり時に遅延分の適用が発生するため切り替わりに時間がかかります。

高可用性用途には向いていません。

複数スレーブ構成にて、1台目位は同期、で2台目を遅延とするする構成が考えられます。

・以下の操作を行うと、遅延レプリケーションの設定(reco very_min _app ly_delay)は無視され、最新の状態まで適用されます。ご注意下さい。

- 再起動 (pg_ctl restart)

- 昇格 (p g _ctl p romote)

・完全同期(syn ch ro n ou s_co mmit= remo te_apply)ではDML(自動コミットがオフの場合はCO M M IT)を待機するため、遅延レプリケーションは使用できませ

ん。

以下の検証を行います。

検証1: 遅延レプリケーションの設定および動作確認

スレーブへの適用が指定した時間分、遅延する事。およびマスタでの遅延確認。

検証2: 問題発生前の状態まで適用

オペレーションミス発生を想定し、発生前の状態まで適用し、昇格。

1. 関連パラメータ

既存のレプリケーションスロットの設定に加え、次のパラメータを指定します。

表 5.10 遅延レプリケーションの設定

サーバサーバ 設定ファイル設 定ファイル パラメ ータパラメ ータ 設定値設定値

スレーブ po stg resq l.con f h ot_stan db y_feedback o n (フィードバックを有効化)

スレーブ recovery.con f reco very_min _app ly_delay 遅延させる時間を指定

2. 検証1:遅延レプリケーションの設定および動作確認

(1)マスタにてテストに使用するテーブルを作成。

(マスタ)

postgres=# CREATE TABLE delay_test(id integer, time1 timestamp);

postgres=# \d delay_test

Table "public.delay_test"

Column | Type | Modifiers

--------+-----------------------------+-----------

id | integer |

time1 | timestamp without time zone |

(2)スレーブで遅延レプリケーションの設定を行い、再起動。

PostgreSQL Enterprise Consortium

Page 27 of 285

(スレーブ)

$ vi $PGDATA/postgresql.conf

[postgresql.conf]

hot_standby_feedback = on

$ vi $PGDATA/recovery.conf

[recovery.conf]

recovery_min_apply_delay = '60min'

$ pg_ctl restart

(3)マスタにてテストテーブルにデータを追加。

(マスタ)

postgres=# INSERT INTO delay_test VALUES (1, localtimestamp);

postgres=# SELECT * FROM delay_test;

id | time1

----+----------------------------

1 | 2018-03-10 18:05:46.29221

(1 rows)

(4)スレーブにて即座に反映されない事を確認。

(スレーブ)

postgres=# SELECT * FROM delay_test;

id | time1

----+-------

(0 rows) <--- INSERTが反映されていない

(5)マスタにて適用の遅延を確認。

pg _stat_replication ビューのrep lay_lag列で確認

(マスタ)

postgres=# SELECT write_lag,flush_lag,replay_lag FROM pg_stat_replication ;

-[ RECORD 1 ]---------------

write_lag | 00:00:00.000323

flush_lag | 00:00:00.00048

replay_lag | 00:00:38.354572 <--- recovery_min_apply_delayに達するまで適用を待機

(6)1時間経過後、スレーブにて適用された事を確認。

(スレーブ)

postgres=# SELECT *,localtimestamp FROM delay_test;

id | time1 | localtimestamp

----+----------------------------+----------------------------

1 | 2018-03-10 18:05:46.29221 | 2018-03-10 19:06:10.521195

(q rows)

(7)マスタにて適用の遅延がクリアされた事を確認。

PostgreSQL Enterprise Consortium

Page 28 of 285

(マスタ)

postgres=# SELECT write_lag,flush_lag,replay_lag FROM pg_stat_replication ;

-[ RECORD 1 ]---------------

write_lag |

flush_lag |

replay_lag |

3. 検証2:問題発生前の状態まで適用

(1)マスタにてテストテーブルにデータを追加。

(マスタ)

postgres=# INSERT INTO delay_test VALUES (2, localtimestamp);

postgres=# SELECT * FROM delay_test;

id | time1

----+----------------------------

1 | 2018-03-10 18:05:46.29221

2 | 2018-03-10 19:30:11.23870

(1 rows)

id = 2の更新(INSERT)をオペレーションミスとみなし、スレーブを更新前の時点まで適用

(2)マスタを停止。

$ pg_ctl stop

(3)スレーブにて1件も反映されない事を確認。

(スレーブ)

postgres=# SELECT * FROM delay_test;

id | time1

----+-------

(0 rows) <--- INSERTが反映されていない

(4)スレーブを停止。

$ pg_ctl stop

(5)スレーブにてreco very.co n fを修正。

$ vi $PGDATA/recovery.conf

[recovery.conf]

restore_command = 'cp <$PGDATAパス>/pg_wal/%f %p' <--- WALのパスを指定

recovery_target_time = '2018-03-10 19:30:00' <--- id=2のCOMMIT直前の時刻

recovery_target_timeline = latest <--- 最新のタイムライン

recovery_target_action = 'promote' <--- 適用中断後、昇格

(6)スレーブにて指定時間までのリカバリおよび昇格(スレーブ→新マスタ)

PostgreSQL Enterprise Consortium

Page 29 of 285

$ pg_ctl start

$ pg_controldata | grep state <--- マスタ/スレーブの確認

Database cluster state: in production <--- マスタ

表 5.11 遅延レプリケーションのPITRログ

メ ッセージメ ッセージ 時間時間

LO G : startin g po int-in -time recovery to 2018-03-10 19:30:00+09 recovery_targ et_time

LO G : reco very stopp in g b efore co mmit of tra n sactio n 578, time 2018-03-10 19:30:11.423701 id = 2のCO MMIT時間

LO G : last co mp leted transaction w as at lo g time 2018-03-10 18:05:46.314276 id = 1のCO MMIT時間

(8)新マスタにてid = 1のみ適用されていることを確認。

postgres=# SELECT * FROM delay_test ;

id | time1

----+---------------------------

1 | 2018-03-10 18:05:46.29221

(1 row)

5.2.8. WAL圧縮圧縮

Fu ll Page W rite時(チェックポイント後の最初の更新時)に、W ALに書き出すフルページイメージを圧縮します。 圧縮されたW ALは適用時に解凍されます。 W ALファイル

のサイズが小さくなるため、書き込み や転送の 時 間短縮書き込み や転送の時 間短縮 が期待されます。 注意点として、圧縮処理および解凍処理が発生するため、通常より余分にCPUを使用しま

す。 適用についてはそれらを総合的に判断します。 一般的な適用場面として、SR構成において効果的と考えられます。 特に以下の構成で有力です。

同期モード(転送まで)または完全同期モード(適用まで)

W AL転送の遅延を懸念して同期モード設定を躊躇する場面でW AL圧縮を検討します。

非同期モードでもW AL圧縮は有力ですが、一定のW AL転送の遅延は許容されるため、

マスタのCPU 負荷を優先してW AL圧縮を適用しないという判断も考えられます。

スレーブの遠隔地配置(ディザスタ・リカバリ)

スレーブを遠隔地に配置する構成において、非同期モードでもW AL転送の遅延が

許容範囲を超える場合にW AL圧縮の適用を検討します。

1. 関連パラメータ

既存のレプリケーションスロットの設定に加え、次のパラメータを指定します。

表 5.12 W AL圧縮の設定

サーバサーバ 設定ファイル設 定ファイル パラメ ータパラメ ータ 設定値設定値

マスタ po stg resq l.con f w al_co mp ressio n 'o n '

5.3. SR環境の監視

5.3.1. レ プリ ケーシ ョン操作ログの 監視レプリ ケーシ ョ ン操作ログの 監視

5.3.1.1. 調査の目的調査の目的

SR構成のサーバログ監視について有益な情報を提示する事を目的としています。

以下の挙動時にサーバログに出力されるメッセージを確認しました。

マスタの起動/停止

スレーブの起動/停止

カスケードスレーブの起動/停止

マスタ側のW AL再利用によるロスト(スロット不使用)

カスケードスレーブ構成時のスレーブ側のW AL再利用によるロスト(スロット不使用)

以下のパターンで検証しました。

レプリケーション操作ログ出力無効時(デフォルト)

PostgreSQL Enterprise Consortium

Page 30 of 285

lo g _replication _co mmand = off

レプリケーション操作ログ出力有効時

lo g _replication _co mmand = on

5.3.1.2. 調査結果調査結果

マスタ側またはスレーブ側のサーバログに出力されるレプリケーション情報についてまとめます。

ホスト名、IPアドレス、ポート番号、ユーザ名、データベース名は例です。

レプリケーション操作ログ出力無効時(デフォルト)

表 5.13 デフォルトで出力される情報

タ イ ミ ングタ イ ミ ング サイトサイト メ ッセージメ ッセージ

スレーブ停止時 マスタ スレーブが複数台存在し、Q u o rum-based 同期レプリケーションを設定していない場合に、

片系スレーブの起動または停止を行うことで同期優先順位が変化した場合のみされます。

STAR T_REPLICATIO N 0/57000000 TIM ELINE 1

マスタ停止時 スレーブ エラーメッセージが繰り返し出力されます。

LO G : in valid record len gth at 132/EF 8AD7F0: w an ted 24, go t 0

FATAL: could not connect to th e primary server: cou ld n o t co n n ect to server: Con n ectio n refu sed

Is th e server run n in g o n h o st "master" (192.168.100.100) and acceptin g

TCP/IP co n n ectio n s o n po rt 5432?

W AL再利用による

ロスト

マスタ エラーメッセージが繰り返し出力されます。

ERRO R : req u ested W AL seg men t 0000001100000132000000EF h as already been removed

W AL再利用による

ロスト

スレーブ エラーメッセージが繰り返し出力されます。

LO G : started streamin g W AL fro m p rimary at 132/EF000000 o n timelin e 17

FATAL: could not receive data from W A L stream: ERRO R : requ ested W AL seg men t

0000001100000132000000EF has already been removed

レプリケーション操作ログ出力有効時

デフォルトで出力される情報に加えて、以下が出力されます。

表 5.14 監視強化時に出力される情報

タ イ ミ ングタ イ ミ ング サイトサイト メ ッセージメ ッセージ

スレーブ起動ま

たは停止時

マスタ スレーブが複数台存在し、Q u o ru m-based 同期レプリケーションを設定していない場合に、

片系スレーブの起動または停止を行うことで同期優先順位が変化した場合のみ出力されます。

LO G : received rep licatio n comman d: IDENTIFY_SYSTEM

LO G : received rep licatio n comman d:

STAR T_REPLICATIO N 0/57000000 TIM ELINE 1

W AL再利用に

よるロスト

マスタ、スレーブ(ス

レーブ出力はカス

ケード・レプリケー

ション時のみ)

エラーメッセージが繰り返し出力されます。

LO G : received rep licatio n comman d: IDENTIFY_SYSTEM

LO G : received rep licatio n comman d: START_REPLICATIO N 134/4A000000 TIM ELINE 17

5.3.1.3. 調査結果調査結果

SR関連のエラーが発生した場合は、デフォルトの設定(log_min _messages= 'w arn ing ')でサーバログに出力されます。

表の太字の文字が監視キーワード候補です。

マスタが停止するとスレーブに出力がありますが、スレーブが単一の構成時にはスレーブが停止してもマスタに出力はありませんでした。

lo g _replication _co mmand による出力はそれほど多くなく、監視に対する影響は限定的です。

ただリロードで反映できることと合わせて、気軽に有効化できるとも言えます。

lo g _min _message = D EB U G [1-5] (例)DEBU G1、DEB U G 2 とすることでもレプリケーション関連のメッセージが出力されます。

ただし影響が大きいため、通常はlo g_replication _comman d を使用します。

lo g _replication _co mmand による出力は、スレーブのw al receiverプロセスからフィードバックされた情報です。

lo g _lin e_prefixにap p lication _name(%a)を設定する事で確認できます。

SQ LSTATEの値をキーワードに監視を行うために、lo g_lin e_prefixパラメータにSQ LSTATE (%e)を設定します。

5.3.2. 同期状況の監視同期状況の監視

非同期レプリケーションを構成した場合、ハードやNW 構成、利用状況によって

マスタとスレーブの同期状況が変化します。

この状態を監視し、同期の遅延が許容範囲内であるかを確認します。

■前提前提

PostgreSQL Enterprise Consortium

Page 31 of 285

構成:

マスタ下に1台または2台のスレーブ構成

マスタ、スレーブに加えカスケードスレーブをスレーブ下に構成する計3台構成

(カスケード・レプリケーション)

バージョン:Po stgreSQ L 10

同期モード:問わない

5.3.2.1. 同期遅延監 視同期遅延監 視

(1)W ALの書き込み位置による同期遅延量を用いて監視することは可能か

「2014年度W G3活動報告書- 可用性編 -」での検証結果をベースに実施します。

マスタのW ALとスタンバイが適応したW ALの2つの差分は、

マスタの最新W ALの書き込み位置(LSN:Log Seq u en ce Numb er)と

スタンバイが適用したW ALの位置(LSN)との差分より算出します。

マスタのLSNは、pg _cu rren t_w al_in sert_lsn ()関数が返す現在のW ALの挿入位置とみなします。

スタンバイのLSNは、統計情報pg _stat_replicatio n ビューのreplay_lsn を使用します。

この2つのLSNの差分をバイト単位で表示するために、pg_w al_lsn _diff関数の引数にそれぞれを格納し

その結果が許容値を超過するかどうかで、監視を行います。

検証には、以下シェルスクリプトで実施しました。

監視通知部については、テストの為、標準出力のみとしています。

PostgreSQL Enterprise Consortium

Page 32 of 285

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

#!/bin/sh

HOST=localhost

LIMIT=1

SLEEPTIME=2

ALERT="echo"

SLAVENUM=2

function send_alert(){

${ALERT} $1

}

IFS_DEFAULT=$IFS

while :

do

val1=$(psql -h $HOST -p 5432 -U postgres -q -t -c "select current_time;")

case $(psql -p 5432 -U postgres -q -t -c "SELECT pg_is_in_recovery();"

|awk '{print $NF}') in

t)

val2=$(psql --no-align -h $HOST -p 5432 -U postgres -q -t -c

"select client_addr,pg_wal_lsn_diff(master,replay_lsn)

as replaydiff from (select pg_last_wal_replay_lsn() master)

as m,pg_stat_replication;")

;;

f)

val2=$(psql --no-align -h $HOST -p 5432 -U postgres -q -t -c

"select client_addr,pg_wal_lsn_diff(master,replay_lsn)

as replaydiff from (select pg_current_wal_insert_lsn() master)

as m,pg_stat_replication;")

;;

esac

rownum=$(psql --no-align -h $HOST -p 5432 -U postgres -q -t -c

"select client_addr,pg_wal_lsn_diff(master,replay_lsn)

as replaydiff from (select pg_current_wal_insert_lsn() master)

as m,pg_stat_replication;" |wc -l)

for slave_lsn in ${val2};

do

if [ ${rownum} -ne ${SLAVENUM} ]; then

send_alert "Slave Down |${val1}"

fi

IFS=$'|'

byte=`echo ${slave_lsn} | awk '{print $NF}'`

if [ ${byte} -gt ${LIMIT} ]; then

send_alert "Replication Delay ${val1},${slave_lsn}"

fi

IFS=${IFS_DEFAULT}

sleep ${SLEEPTIME}

done

done

今回の検証でスレーブが複数存在する場合も、それぞれのスレーブの遅延状況を検知することが可能であることがわかりました。

監視シェルを実行中にinsert文を実行した結果を記載します。

以下の通り、遅延状況を検知でき、メールサーバ等に連携することで監視することが可能です。

また間接的に更新待ち監視も行うことができます。詳細は、更新・読取監視の項に記載します。

PostgreSQL Enterprise Consortium

Page 33 of 285

$ ./delay_test.sh

Replication Delay 20:58:18.451839+09,192.168.100.101 11880

Replication Delay 20:58:18.451839+09,192.168.100.102 11880

Replication Delay 20:58:22.484532+09,192.168.100.101 11880

Replication Delay 20:58:22.484532+09,192.168.100.102 11880

Replication Delay 20:58:26.512656+09,192.168.100.101 12048

Replication Delay 20:58:26.512656+09,192.168.100.102 12048

Replication Delay 20:58:30.538009+09,192.168.100.102 12048

尚、カスケードスレーブ構成の場合にはスレーブ上で同シェルスクリプトを実行することで、

カスケードスレーブとの同期の遅延状況を検知することが可能です。

5.3.3. 更新、 読み 取りの監視更新、 読み 取りの監視

非同期レプリケーションを構成した場合、ハードやNW 構成、利用状況によってマスタとスレーブの同期状況が変化します。

この状態を監視し、同期の遅延が許容範囲内であるかを確認します。

■前提構成前提構成

3ノード構成

1. 複数スレーブ方式(親 - 子1 , 子2) スレーブ2はマスタと繋がっている。

2. カスケード方式(親 - 子 - 孫) スレーブ2はスレーブ1と繋がっている

同期モード:同期または完全同期 (syn ch ro n ou s_co mmit = on / remote_apply)

5.3.3.1. 更新・ 読取監視更新・ 読 取監視

(1)Po stgreSQ Lの機能により監視することは可能か

- 検証方法

Po stgreSQ Lの内部パラメータ(statemen t_timeou t)により、マスタへの更新処理に対して

スレーブ停止によって一定時間応答がない場合に接続を切断し、アラート通知することは可能かを検証を行いました。

statemen t_timeou tは、po stgresql.co n f内での設定は推奨されていない為、SQ L発行時に設定しました。

また、pg_stat_rep licatio n ビューにより間接的に、検知できないかについて検証を行いました。

- 検証結果

statement_timeoutを設定しSQ Lを発行しましたが、有効に機能せず

Ctrl+ Cをキーインするまで停止しないという結果となりました。

複数台のスレーブのうち1つでも稼働している場合には設定時間を待たずに

PostgreSQL Enterprise Consortium

Page 34 of 285

一方のスレーブの応答をもって処理が完了してしまうため、他のスレーブの同期遅延の検知ができないという結果となりました。

全て のスレーブが応答不可 能である場合全て のスレーブが応答不可 能である場合

$ psql -U postgres -d testdb -q -t << EOF

> \timing on

> SET statement_timeout TO 5000;

> insert into test(id) values(1);

> delete from test where id=1;

> EOF

時間: 0.192 ms

^CCancel request sent

WARNING: canceling wait for synchronous replication due to user request

DETAIL: The transaction has already committed locally, but might not have been

replicated to the standby.

時間: 13626.496 ms

一方のスレーブのみ 応答が可能 である場 合一方のスレーブのみ 応答が可能 である場 合

$ psql -U postgres -d testdb -q -t << EOF

> \timing on

> SET statement_timeout TO 5000;

> insert into test(id) values(1);

> delete from test where id=1;

> EOF

Time: 0.147 ms

Time: 1.899 ms

Time: 1.277 ms

pg_stat_rep licatio n ビューについては、スレーブサーバ停止時にレコードが取得できなくなる為

この点を利用することで間接的に、同期待ちを検知することが可能であることがわかります。

testdb=# select * from pg_stat_replication;

pid | usesysid | usename | application_name | client_addr | client_hostnam

e | client_port | backend_start | backend_xmin | state | sen

t_lsn | write_lsn | flush_lsn | replay_lsn | write_lag | flush_lag | flush_lag |

sync_priority | sync_state

-------+----------+---------+------------------+----------------+---------------

--+-------------+-------------------------------+--------------+-----------+----

-----------+----------------+----------------+-----------------+---------------+

------------

(0 行)

(2)O Sコマンドなどの外部機能により、更新処理に対して一定時間応答がない場合を監視する

スレーブが単一であればtimeou tコマンドにより、指定秒数で強制切断に成功し、

スタンバイと同期が取れていないメッセージが出力されます。

また終了値として、124が返却されている為、全てのスレーブが応答できない場合に限り、

メッセージ内容または、終了値を制御することでスレーブサーバ障害による同期待ちを検知することが可能です。

スレーブが単一 である場 合スレーブが単一 である場 合

PostgreSQL Enterprise Consortium

Page 35 of 285

$ timeout -sINT 5 psql -U postgres -d testdb -q -t << EOF

> \timing on

> insert into test(id) values(1);

> delete from test where id=1;

> EOF

Cancel request sent

WARNING: canceling wait for synchronous replication due to user request

DETAIL: The transaction has already committed locally, but might not have been

replicated to the standby.

Time: 4994.166 ms (00:04.994)

[postgres@test_pg01 data]$ echo $?

124

しかし statemen t_timeou t設定による検証のケースと同様に、複数台のスレーブのうち1つでも稼働している場合には

設定時間を待たずに一方のスレーブの応答をもって処理が完了してしまうため、

他のスレーブの同期遅延の検知ができないという結果となりました。

一方のスレーブのみ 応答が可能 である場 合一方のスレーブのみ 応答が可能 である場 合

$ timeout -sINT 5 psql -U postgres -d testdb -q -t << EOF

> \timing on

> insert into test(id) values(1);

> delete from test where id=1;

> EOF

Time: 2.382 ms

Time: 1.246 ms

[postgres@test_pg01 data]$ echo $?

0

5.3.4. スプリッ トブレインの監視スプリットブレインの監視

5.3.4.1. スプリットブレインの 定義と調査の目的スプリットブレインの 定 義と調査の目的

SR構成においては、通常はマスタの障害を検知した場合にスレーブを昇格させます。つまりマスタは常に1台のみです。 ただしオペレーションミスにより、マスタが正常な状態

にもかかわらずスレーブを昇格させてしまうという事も有り得ます。 稼働中のマスタ(シングル)が2台という危険な状態になります。その状態をスプリットブレインと定義します。

その場合でも全てのアプリケーションが元のマスタにのみ接続していれば問題ありませんが、 2台目のマスタにも接続が発生するとデータの整合性が損なわれてしまいます。

それを避けるため、スプリットブレイン状態になっていないかの監視の方法を検討します。

5.3.4.2. 監視方法監視方法

以下の監視についてまとめます。

サーバログの監視

pg _co n trold ataコマンドによる監視

pg _co n trol_recovery関数による監視

pg _is_in _recovery関数による監視

5.3.4.3. サーバログの監視サーバログの監視

pg _ctl p romo te コマンドにより昇格した場合は、昇格したノードのサーバログに以下のメッセージが出力されます。 timelin e IDが変化が変化 した事が分かります。

received promote request

selected new timeline ID: XX

マスタ稼働中にスレーブ側にこのようなメッセージが出力されていないかを監視します。

注意点

recovery.con fを削除(または改名)した後に再起動する事でマスタ(シングル)として起動する方法もあります。

ただし timelin e ID の変化がなく、特徴的なメッセージは出力されません。状態変更の捕捉が困難です。

5.3.4.4. pg_controldataコ マンドに よる監視コ マンドに よる監視

PostgreSQL Enterprise Consortium

Page 36 of 285

5.3.4.4. pg_controldataコ マンドに よる監視コ マンドに よる監視

pg _co n trold ataコマンドは制御ファイル($PG DATA/g lobal/p g _co n trol)の状態を表示します。

以下に実行例を示します。ここでは環境変数LANGの設定により英語で表示しています。

(実行例)

$ export LANG=C

$ pg_controldata

pg_control version number: 1002

Catalog version number: 201707211

Database system identifier: 6514575400714084610

Database cluster state: in archive recovery

~以下略~

多数の項目がありますが、ここでは"Datab ase clu ster state"に着目します。 必要な項目のみ抽出する例です。

(スレーブでの実行例)

$ pg_controldata | grep "Database cluster state"

Database cluster state: in archive recovery

4種類の状態があります。

マスタ/スレーブ

稼働中/停止中

表 5.15 Datab ase clu ster stateで表示される値

表示され る値表示され る値 (英語)英語) 表示され る値表示され る値 (日本語)日本語) 意 味意 味

in pro du ction 運用中 マスタとして稼働中

in arch ive recovery アーカイブリカバリ中 スレーブとして稼働中

shu t d o w n シャットダウン マスタとして停止中

shu t d o w n in recovery リカバリしながらシャットダウン中 スレーブとして停止中

"in arch ive reco very"はPITRとしてのリカバリ中の場合も含みますが、ここではスレーブ状態の意味です。

カスケード・レプリケーション構成の場合は、スレーブもリカバリ中との取り扱いになるため

カスケードスレーブと同様にスレーブ状態に準じた状態が表示されます。

両ノードとも"in pro d u ction "状態でない事を確認します。

ssh コマンドでリモートの状態を容易に取得できます。

注意点としては、リモート側の環境変数を認識しないため、明示的に指定する必要があります。

以下はローカルとリモートで同一設定の前提です。

(スプリットブレインの状態下での実行例)

$ ssh <remote> $PGHOME/bin/pg_controldata $PGDATA | \

> grep "Database cluster state"

Database cluster state: in production

5.3.4.5. pg_control_recoveryコマンドに よる監視コ マンド に よる監視

pg _co n trol_recoveryは制御ファイルの情報をpg _co n trold ataコマンドに代わり取得する方法です。

取得できる項目は限られていますが、SELECT文で取得できるという特徴があります。

状態監視の選択肢の一つとしてご認識下さい。

(スレーブでの実行例)

PostgreSQL Enterprise Consortium

Page 37 of 285

=# SELECT pg_control_recovery();

pg_control_recovery

-----------------------------

(0/5E0001B0,1,0/0,0/0,f)

(1 行)

カンマ区切りにより5項目から構成されています。何れもpg_co n troldataコマンドでも取得できます。

表 5.16 p g _con trol_reco very関数の表示内容例

項目項目 マスタマスタ スレーブスレーブ

min _recovery_end _lsn 0/0 0/15000178

min _recovery_end _timelin e 0 1

backu p _start_lsn 0/0 0/0

backu p _end _lsn 0/0 0/0

end _o f_backu p _reco rd _required f f

min _recovery_end _lo catio n および min_recovery_en d _timelineにマスタとスレーブの違いが表れます。

ただしpg _co n trold a taコマンドによる監視と同様、カスケード・レプリケーション構成の場合は

スレーブもリカバリ中との取り扱いになるため、例外的にカスケードスレーブとの違いが表れません。

5.3.4.6. pg_is_in_recovery関数に よる監視関数による監視

リカバリ中かどうかを示します。 マスタであれば f (false) 、スレーブであれば t (tru e) を表示します。

(スレーブでの実行例)

=# SELECT pg_is_in_recovery();

pg_is_in_recovery

-------------------

t

(1 行)

両ノードとも f (false) 状態でない事を確認します。

5.4. SR環境の障害時運用

5.4.1. 本文書におけ る用語の定義本文書にお け る用語の定義

5.4.1.1. フェ イルオーバフェ イルオーバ

マスタへの障害発生時やアクセス不能時に、スレーブをマスタへ昇格させる処理を指します。

新マスタはシングル構成であり、レプリケーションされていない片系運用の状態です。

レプリケーション構成への復旧には後述の「フェイルバック」を実行しますが、

マスタの障害がインスタンス障害など、データファイルの障害でない場合は、「スイッチオーバ」が可能な場合もあります。

5.4.1.2. フェ イルバックフェ イルバック

フェイルオーバにより片系運用になった後、再度レプリケーション構成に復帰させる処理を指します。

シングル構成となった新マスタに、新スレーブを追加します。

新マスタと新スレーブを交代させてフェイルオーバ前に戻すことまでは含まない事とします。

複数スレーブ構成では、不要な処理となります。

PostgreSQL Enterprise Consortium

Page 38 of 285

5.4.1.3. スイッチ オーバスイッチオーバ

マスタとスレーブを入れ替える処理を指します。

マスタを停止し、スレーブを新マスタへ昇格させ旧マスタを新スレーブとして再追加します。

マスタのメンテナンスのための一時的な入れ替えなどが目的です。

フェイルオーバーとの違いは、マスタ停止が障害による停止か計画停止かであり、スレーブに対する処理は同様です。

5.4.1.4. スイッチ バックスイッチ バック

スイッチオーバ後に、マスタ/スレーブを入れ替えることを指します。

マスタ/スレーブとの関係性を除き処理内容は、「スイッチオーバ」と同様です。

PostgreSQL Enterprise Consortium

Page 39 of 285

5.4.2. 障害時運用手順(障害時運用手順( 2ノー ド構成)ノー ド構成)

■前提 以降の手順では次の前提とします。

Po stg reSQ L 10.1

マスタ、スレーブの2台構成(ホスト名をそれぞれ server1,server2と表記する)

同期モードは同期(syn ch ro n o u s_co mmit = on または remo te_apply)

スレーブはホットスタンバイ機能により参照可能 (ho t_stand b y = on )

レプリケーション用のユーザは rep _user

マスタ/スレーブとも、portは5432を使用

レプリケーションスロット使用

マスタ/スレーブとも、環境変数PG D ATA,PG PO R Tは設定済み

死活監視は実際の運用ではクラスタソフトを使用するのが一般的ですが、ここでは便宜上手動で実施

サーバのNICはパブリックのみ

仮想IPについては考慮しない

■対処一覧 大別すると3種類の対処方法が考えられます。

PostgreSQL Enterprise Consortium

Page 40 of 285

表 5.17 障害別の対処

ID

障害箇障害箇

所所 障害状況障害状況 pg_basebackupとと pg_rew indの使い 分けの使い分け

1 マスタ マスタとスレーブの関係が崩れており再構成が必要

物理障害

pro mo teを伴わないスレーブのマスタ化(reco very.con f削除)

pg _b aseb acku pコマンドを使用してフェイルバック

2 マスタ マスタとスレーブの関係は巻き戻しで復旧可能

非同期レプリケーションのインスタンス障害(差異がある状態で昇格)

スプリットブレイン状態での旧マスタへの更新

pg _rew in dコマンドを使用してスイッチバック

3 マスタ マスタとスレーブの切り替え可能

計画停止

同期レプリケーションのインスタンス障害(物理障害なし)

pg _rew in dコマンドを使用しないでスイッチバック

4 スレーブ マスタとスレーブの連携再開可能

スレーブの障害

同期式の場合は非同期式に切り替え

5.4.2.1. フェ イルオーバフェ イルオーバ

フェイルオーバについて記載します。

マスタにて、障害が発生した場合のスレーブを新マスタへ昇格したシングル構成図

(1) マスタの疑似障害発生

immed iateオプションにて停止、またはpo stg resプロセスのkillする事で擬似障害を発生させます。

マスタにて実行します。

$ pg_ctl -w -m immediate stop

$ kill -9 `head -1 $PGDATA/postmaster.pid`

(2) マスタの死活監視にて異常を検知

死活監視の方法には多数ありますが、ここではpg_isread yコマンドを使用します。

pg _isreadyコマンドはクライアントツールですので、任意のノードから実行できます。

$ pg_isready -h server2 -U postgres -d postgres

server2:5432 - no response

(3) スレーブを新マスタへ昇格

旧スレーブで実行します。

$ pg_ctl promote

※サーバログに下記内容が記載されること

"d a tab ase system is ready to accept co n n ection s"

ただしこの時点ではsyn ch ro n ou s_stan d b y_namesパラメータに値が設定されているため、新マスタで更新処理ができない状態です。

PostgreSQL Enterprise Consortium

Page 41 of 285

(4) 新マスタを非同期に切り替え

syn ch ro n o u s_stan d b y_n amesパラメータの設定を''に設定し、リロードで反映します。

新マスタで実行します。

$ vi $PGDATA/postgresql.conf

[編集前]

synchronous_standby_names = '*'

[編集後]

synchronous_standby_names = ''

$ pg_ctl reload

これで更新処理ができる状態になりました。

(5) 新マスタの死活監視にて正常を確認

$ pg_isready -h server2 -U postgres -d postgres

server2:5432 - accepting connections

以上でファイルオーバーは完了です。

5.4.2.2. フェ イルバックフェ イルバック

pg _b aseb acku pを使用したフェイルバックについて記載します。 初期構築手順とほぼ同じです。

マスタ障害発生によるフェイルオーバ後、旧マスタを新スレーブとしたレプリケーション構成図

■パラメータ

pg _b aseb acku pに必要な設定を記載します。

表 5.18 p g _baseb acku p に必要な設定

サーバサーバ 設定ファイル設 定ファイル パラ メ ー タパラ メ ー タ 設定値設定値 内容内容

マスタ po stg resq l.con f listen _add ress 0.0.0.0 全てのIPアドレス(v4)からの接続を受け付ける

マスタ po stg resq l.con f max_w al_send ers 2 W ALストリームオプションを付与する場合は、2以上を設定

■p g _baseb acku p コマンド

pg _b aseb acku pコマンドの主なオプションは次の通りです。

PostgreSQL Enterprise Consortium

Page 42 of 285

表 5.19 p g _baseb acku p のオプション

オプショ ンオプショ ン 内容内容

-D < d irecto ry> 出力を書き出すディレクトリを指定。

-X < meth o d>

--w al-metho d = < meth o d>

必要なW ALファイルをバックアップに含める。metho d (収集方式)は以下から選択。

fetch :W ALファイルは最後に収集

stream:バックアップ作成中に同時にW ALをストリームで収集

運用中にp g _baseb acku p を実行する場合には stream を指定する。

fetch (最後に収集)では、必要なW ALファイルが削除される可能性があるため。

-S < slot_n ame>

--slo t=< slo t_n ame>

W ALストリーミングの収集に指定したレプリケーションスロットを使用。

-X stream とセットで指定。

必要なW ALファイルが削除されるのを防ぐ事を目的とする。

運用中にp g _baseb acku p を実行する場合に使用を検討する。

以下に注意する。

事前にレプリケーションスロットを作成する必要がある

マスタのW AL領域の空きが十分である事を確認する

-R

--w rite-reco very-co n f

最低限のreco very.con fを作成。必要に応じてreco very.co n fを加筆修正。

-r < rate>

--max-rate=< rate>

サーバから転送されるデータの最大転送速度を指定。

運用中にp g _baseb acku p を実行する場合に使用を検討する。

転送速度を抑える事で、マスタに対する影響を制限する事を目的とする。

-P 進行状況報告を有効化。

pg _b aseb acku p処理中におおよその進行状況を報告する。

運用中に実行した場合、データベースクラスタのサイズが増加して進行状況が100%を超える場合があ

る。

-v 冗長モードを有効化。

進行状況報告も有効な場合、現在処理中のファイル名を出力。

pg _b aseb acku pでレプリケーションスロットが使用できます。 W AL収集方式に stream を指定する事でW ALをほぼ確保できますが、スロットを指定する事でより確実にな

ります。 スロットを使用する運用であれば、この段階で作成するのが有力です。

■フェイルバック手順

pg _b aseb acku pにスロットを指定する場合を記載します。

(1) 旧マスタのデータベースクラスタを削除

旧マスタにて実行します。

$ rm -rf $PGDATA/*

※$PG DATA以外に表領域を作成している場合、そのファイルも削除します。

※$PG DATAディレクトリを削除する場合は、postgresユーザで$PGDATAディレクトリを作成できるよう

親ディレクトリのオーナーまたはパーミッションを設定します。

(2) レプリケーションスロットの作成

新マスタにて実行します。

PostgreSQL Enterprise Consortium

Page 43 of 285

$ psql

=# SELECT pg_create_physical_replication_slot('slot_server1',true); -- 第2パラメータにtrueを指定

pg_create_physical_replication_slot

-------------------------------------

(slot_server1,144/EEFC8940)

(1 行)

=# \x on

拡張表示は on です。

=# SELECT * FROM pg_replication_slots ;

-[ RECORD 1 ]-------+-------------

slot_name | slot_server1

plugin |

slot_type | physical

datoid |

database |

active | f -- まだスロットは使用されてないため false

active_pid |

xmin |

catalog_xmin |

restart_lsn | 144/EEFC8940 -- trueの指定により、作成直後からrestat_lsnを認識

confirmed_flush_lsn |

(3) p g _basebacku p コマンドにて、新マスタからデータベースクラスタをコピー

旧マスタにて実行します。

$ pg_basebackup -h server2 -U rep_user -D $PGDATA -X stream -S slot_server1 -P -v -R

transaction log start point: 144/F3000028 on timeline 17

pg_basebackup: starting background WAL receiver

10503022/10503022 kB (100%), 1/1 tablespace

transaction log end point: 144/F3000130

pg_basebackup: waiting for background process to finish streaming ...

pg_basebackup: base backup completed

(4) recovery.con fの修正

旧マスタにて実行します。

pg _b aseb acku pにて-Rオプションを指定した事で、reco very.con fが作成されます。

スロットを指定している事から、primary_slot_n ameの指定があります。以下を追記します。

recovery_targ et_timelin eパラメータ

primary_co n n infパラメータにapp licatio n _nameを追加(任意/デフォルトはw alreceiver)

$ vi $PGDATA/recovery.conf

[編集前]

standby_mode = 'on'

primary_conninfo = 'user=rep_user host=server2 port=5432 sslmode=prefer sslcompression=1'

primary_slot_name = 'slot_server1'

[編集後]

standby_mode = 'on'

primary_conninfo = 'user=rep_user host=server2 port=5432 application_name=slave_server1

asslmode=prefer sslcompression=1'

primary_slot_name = 'slot_server1'

recovery_target_timeline = latest

(5) 旧マスタのp o stgresql.co n fの修正

旧マスタにて、パラメータの調整を行います。

syn ch ro n o u s_stan d b y_n amesパラメータの無効化

pg _statsin foの無効化(有効化されている場合)

同期レプリケーションの設定を無効化します。

PostgreSQL Enterprise Consortium

Page 44 of 285

新スレーブのsh ared _prelo ad_lib rariesパラメータに p g _statsinfoが設定されている場合は、書き込みができずにエラーが発生します。

pg _statsin foの指定を削除します。

$ vi $PGDATA/postgresql.conf

[編集前]

synchronous_standby_names = '*'

shared_preload_libraries = 'pg_stat_statements,pg_statsinfo'

[編集後]

synchronous_standby_names = ''

shared_preload_libraries = ''

(6) 新スレーブの起動

新スレーブを起動します。

$ pg_ctl start

(7) 新マスタでのレプリケーション確認

pg _stat_replication sビューを参照して、レプリケーション構成である事を確認します。

pg _replication _slotsビューを参照して、スロットがアクティブである事を確認します。

$ psql

=# SELECT * FROM pg_stat_replication;

-[ RECORD 1 ]----+------------------------------

pid | 11262

usesysid | 16384

usename | rep_user

application_name | slave_server1

client_addr | <新スレーブIP>

client_hostname |

client_port | 44548

backend_start | 2017-03-22 06:36:06.362576+09

backend_xmin | 1781

state | streaming --- ストリーミング中

sent_location | 0/10000060

write_location | 0/10000060

flush_location | 0/10000060

replay_location | 0/10000000

sync_priority | 2

sync_state | async --- 非同期

=# SELECT slot_name,active FROM pg_replication_slots;

-[ RECORD 1 ]-------+-------------

slot_name | slot_server1

active | t --- アクティブ

(8) レプリケーション方式を同期式に変更

新マスタにて、syn ch ro n ou s_stan d b y_n amesパラメータを設定し、リロードで反映します。

$ vi $PGDATA/postgresql.conf

[編集前]

synchronous_standby_names = ''

[編集後]

synchronous_standby_names = '*'

$ pg_ctl reload

PostgreSQL Enterprise Consortium

Page 45 of 285

$ psql -h server2 -U postgres postgres -c "SELECT * FROM pg_stat_replication" -x

-[ RECORD 1 ]----+------------------------------

pid | 11262

usesysid | 16384

usename | rep_user

application_name | s1

client_addr | <新スレーブIP>

client_hostname |

client_port | 44548

backend_start | 2017-03-22 06:36:06.362576+09

backend_xmin | 1781

state | streaming --- ストリーミング中

sent_location | 0/10000060

write_location | 0/10000060

flush_location | 0/10000060

replay_location | 0/10000000

sync_priority | 2

sync_state | sync --- 同期

これにて、以下の構成に復旧しました。

レプリケーションスロット使用

同期式レプリケーション構成

5.4.2.3. スイッチ オーバスイッチオーバ

スイッチオーバについて記載します。

■スイッチオーバ手順

計画停止におけるマスタ/スレーブの切り替え手順です。 p g _baseb acku p やpg_rew ind が不要であるためシンプルな手順です。

計画停止にてマスタとスレーブの役割を切り替えたレプリケーション構成図

(1) マスタの正常停止

マスタにて実行します。

$ pg_ctl stop -m fast

(2) スレーブの昇格

スレーブにて実行します。

以下の場合にはpg _rew in d 不要です。

計画停止

同期レプリケーションのインスタンス障害(物理障害なし)

$ pg_ctl promote

以降の手順はフェイルオーバの場合と同様であるため省略します。

3. レプリケーションスロットの作成

4. recovery.con fの作成

PostgreSQL Enterprise Consortium

Page 46 of 285

5. 旧マスタのpo stg resq l.con fの修正

6. 新スレーブの起動

7. 新マスタでのレプリケーション確認

8. レプリケーション方式を同期式に変更

(9) レプリケーションスロットの削除(スレーブ)

フェイルオーバとの違いとしては、新スレーブに旧マスタ時代のスロットが残る事があります。

restart_lsn列に値が残っている状態では、マスタのVACUU M 処理を阻害するなどの

悪影響の可能性があるため、削除します。

スロットの削除は関数で行うため、スレーブでも実行可能です。

$ psql

=# SELECT pg_drop_replication_slot('slot_server2');

pg_create_physical_replication_slot

-------------------------------------

(1 row)

=# SELECT slot_name FROM pg_replication_slots ;

(0 rows)

以上でスイッチオーバが完了しました。

5.4.2.4. スイッチ バックスイッチ バック

pg _rew in dを使用したスイッチバックについて記載します。

pg _rew in dはタイムラインのずれたレプリケーションを再同期させる機能です。 実行後、ターゲットクラスタはソースクラスタと置き換えられた状態になります。 そのため

pg _rew in d後の操作は、通常のフェイルオーバ時と同じです。 タイムラインの分岐点からソースクラスタのW ALを適用するため、更新量が少なければpg_basebackによる

複製より高速です。 これによりフェイルオーバ時、旧マスタを容易に新スレーブとして起動させることができます。

スイッチオーバー後に役割を元に戻したレプリケーション構成図

■関連パラメータ

pg _rew in dに必要な設定を記載します。

表 5.20 p g _rew ind に必要な設定

サーバサーバ 設 定ファイ ル設定ファイル パラメ ータパラメ ータ 設定値設定値 内容内容

マスタ postgresq l.con f full_p age_w rites on チェックポイント後の更新時、ディスクページの全内容をW ALに書き込

む。

マスタ postgresq l.con f w al_log_h ints on ヒントビット更新時もfu ll_p age_w ritesを実行する。

■p g _rew indコマンド

PostgreSQL Enterprise Consortium

Page 47 of 285

pg _rew in dコマンドのの主なオプションは次の通りです。

表 5.21 p g _rew ind のオプション

オプショ ンオプショ ン 内容内容

D <ターゲットクラスタ> pg _rew in dを実行し、ソースクラスタの内容に置き換えるクラスタを指定する。

sou rce-server= "<ソースクラスタ> "

同期対象であるソースクラスタを指定します。主に次の接続文字列を使用します。

h ost:ソースクラスタのホスト名またはIPアドレス

po rt:ソースクラスタのポート番号

db n ame:ソースクラスタの接続先データベース名

u ser:ソースクラスタの接続先ユーザ

P 進行状況をレポートとして表示する。

■スイッチバック手順

※事前にマスタ/スレーブで(1) 関連パラメータの設定がされていることを前提とします。

(1) 旧マスタの正常停止

pg _rew in dを使用するには正常停止する必要があります。

停止した旧マスタを一旦起動した後、正常停止させます。

障害により正常に起動や停止ができない状態ではp g _rew indは使用できません。

その場合は、pg _b aseb acku pを使用します。

$ pg_ctl start -w

$ pg_ctl stop -m fast -w

(2) p g _rew indの実行

旧マスタでp g_rew in d を実行する。

$ pg_rewind -D $PGDATA --source-server="host=server2 port=5432"

servers diverged at WAL position 0/5015B70 on timeline 1

rewinding from last common checkpoint at 0/5015B00 on timeline 1

Done!

(3) スレーブのrecovery.con fを編集

旧マスタの$PG DATA配下にreco very.con fを作成し、以下を設定します。

$ vi $PGDATA/recovery.conf

[編集後]

standby_mode = 'on'

primary_conninfo = 'host=server2 port=5432 user=rep_user'

recovery_target_timeline = 'latest'

(4) 新スレーブを起動し、新マスタとタイムラインID が揃っていることを確認する。

タイムラインIDの取得には、p g _con tro ld ataコマンドを使用する。

厳密には最新チェックポイント実行時のタイムラインIDであるため、

タイムラインIDが揃っていないときは、マスタにてチェックポイント実行後、再確認します。

ssh 経由で実行する事で任意のノードから全データベースクラスタの情報が取得できる。

PostgreSQL Enterprise Consortium

Page 48 of 285

[新マスタ]

$ export LANG=C

$ pg_controldata | grep " TimeLineID"

Latest checkpoint's TimeLineID: 2

$ ssh server1 $PGHOME/bin/pg_controldata $PGDATA | grep " TimeLineID"

Latest checkpoint's TimeLineID: 2

■p g _rew ind使用時の注意点

正常停止が必要

pg _rew in dを実行するデータベースクラスタは正常終了しなければいけません。

物理障害等により正常停止できない場合、p g _rew in d は使用できません。p g _basebacku p を使用します。

同一タイムラインの場合は実施不可

pg _p romoteを実行せずに旧スレーブを新マスタにした場合、新マスタのタイムラインID は変わらないため、

新マスタと旧マスタのタイムラインIDは同じ状態です。

この場合は、p g _rew in d は実行できません。

実行時期と所要時間の関係

pg _rew in dによるフェイルバックの所要時間は2つの要素から構成されます。

Step 1. pg_rew ind による巻き戻し (旧マスタのW ALを使用)

Step 2. W AL適用による追い付き (新マスタのW ALを使用)

新マスタで大量更新がある場合は、Step1は短時間で終了してもStep2で時間がかかります。

結果として、p g _basebacku pの方が効率が良い場合もあり得ます。

また新マスタ昇格時のW ALが削除されている場合は、後述するようにStep2でエラーとなる可能性もあります。その場合はpg_basebacku p

が必要となります。

pg _rew in dはフェイルオーバー後、あまり時間を置かずに実行する事がポイントです。

旧マスタのW AL削除

旧マスタの巻き戻しに必要な旧マスタのW ALが削除されているいる場合、pg_rew in d は失敗します。

例えば旧マスタが障害により大量更新の途中で異常終了した場合などに発生します。

pg _rew in d実行時に次のようなエラーが発生します。

could not open file "/home/pg96/pg96_data/pg_xlog/0000000D00000002000000CF": No

such file or directory

could not find previous WAL record at 2/CF000140

Failure, exiting

pg _rew in dが成功するかどうかは検証(d ry-ru n オプション)にて事前に確認する事ができます。

$ pg_rewind -D $PGDATA --source-server="host=server2 port=5432" --dry-run

servers diverged at WAL position 0/5015B70 on timeline 1

rewinding from last common checkpoint at 0/5015B00 on timeline 1

Done!

| メッセージはdry-runオプションが無い場合と同じです。

| pg_rewindでエラーが発生する場合(スレーブのWAL削除)は、この検証にて確認できますが、

| pg_rewindでエラーが発生しないで、後から発生する場合(マスタのWAL削除)は検知できません。

| 検証の仕様について認識下さい。

新マスタのW AL削除

pg _rew in d後、新スレーブは新マスタのW ALを適用することで、新マスタと同期します。

新マスタに昇格時のW ALファイルが残っていない場合、新スレーブは追い付きができず、次のエラーがサーバログに出力され続けます。

PostgreSQL Enterprise Consortium

Page 49 of 285

対策としてレプリケーションスロットの有効化が有力ですが、新マスタのW AL領域の枯渇にご注意下さい。

ERROR: requested WAL segment 0000000D00000000000000F3 has already been removed

タイムラインの巻き戻し

pg _rew in dはPostgreSQ L9.6からタイムラインの巻き戻しができるよになっています。

これによりスプリットブレインが発生しても、新マスタをスレーブに戻すことが可能です。

pg _rew in dが不要な場合

pg _rew in dはターゲットとソースクラスタのタイムラインIDが分岐した場合に実行が必要です。

そのためタイムラインが枝分かれしなかった場合、pg_rew ind を実行する必要はありません。

例えばpg_rew in d 実行時に次のようなメッセージが出た場合、pg _rew in d は実行せずに、以降の操作を継続します。

servers diverged at WAL position 0/503A428 on timeline 2

no rewind required

5.4.2.5. スレー ブ障害による対処スレーブ障害による対処

スレーブ障害時の緊急対応の必要性は、非同期モードが同期モードかによって異なります。

非同期モードの場合は、スレーブ障害がマスタの更新処理を阻害しないため、緊急対応は必要ありません。

とはいえ、シングル状態であるため早期にレプリケーション構成に復旧します。

同期モードの場合は、スレーブ障害 に よりマスタ の更新処理が阻害さ れ ハング状態となりますスレーブ障害により マスタ の更新処理が阻害さ れ ハング状態となります 。

$ psql -h server1 -U postgres postgres -c "INSERT INTO test1_t VALUES ( 1 )"

Cancel request sent

WARNING: canceling wait for synchronous replication due to user request

DETAIL: ** The transaction has already committed locally, but might not have been replicated to

the standby. **

INSERT 0 1

※Ctrl+Cをキーインする等、意図的にキャンセルしない限り、応答が返ってきません。

そのため、直ちに非同期に設定する必要があります。

非同期への切り替え処理は以降に示す様に再起動不要であるため、即時対応が可能です。

非同期への切り替えではなく、スレーブの再起動を試みる方法も考えられます。その方が効率的のようにも考えられます。

即座に起動できればその通りですが、起動に時間がかかる、あるいは物理的な障害で起動できない状態である事も考えられます。

そのような試行錯誤より、まずは確実にマスタのハング状態解消を優先します。

マスタの復旧後は、スレーブの復旧を試みます。

物理障害により起動できない場合は、フェイルバック処理と同様の作業を行います。

(1) スレーブの疑似障害発生

immed iateオプションにて停止、またはpo stg resプロセスのkillする事で擬似障害を発生させます。

スレーブにて実行します。

$ pg_ctl -w -m immediate stop

(2) スレーブの死活監視にて異常を検知

死活監視の方法には多数ありますが、ここではpg_isread yコマンドを使用します。

PostgreSQL Enterprise Consortium

Page 50 of 285

pg _isreadyコマンドはクライアントツールですので、任意のノードから実行できます。

$ pg_isready -h server2 -U postgres -d postgres

server2:5432 - no response

(3) 非同期モードに切り替え

syn ch ro n o u s_stan d b y_n amesパラメータを''に設定する事で、非同期の設定となります。

$ vi $PGDATA/postgresql.conf

[変更前]

synchronous_standby_names = '*'

[変更後]

synchronous_standby_names = ''

$ pg_ctl reload

(4) 非同期モードの確認

レプリケーションモードが非同期(asyn c)に変更された事を確認します。

$ psql -At -c "SELECT sync_state FROM pg_stat_replication;"

async

これでマスタが更新処理が可能な状態に復旧しました。 ただしシングル状態であるため、フェイルオーバと同様の作業を行います。

5.4.3. 障害時運用手順(複数スレー ブ)障害時運用手順( 複数スレー ブ)

■同期モードについて

スレーブが複数ある場合、障害時にどのスレーブを新マスタに昇格するかが重要になります。 基本的には同期運用しているスレーブを昇格すべきですが、同期対象も複数

選べるため、どの同期スレーブを優先するかが問題です。

これに対しPostgreSQ Lは、通常の同期運用では、同期優先度を明確にすることで、昇格すべきスレーブを絞っています。 しかし同期優先度が明確な場合、同期対象ス

レーブの性能に、マスタ側も大きく影響を受けます。 そのため複数同期においても、最も処理が進んでいるスレーブを同期対象とすることでスレーブの影響を抑えるクォーラム

コミットという機能が用意されています。

ただしクォーラムコミットの場合、最も同期が進んでいるスレーブがその時によって異なるため、運用に工夫が必要です。 性能面と運用面のトレードオフを考慮した上で、同

期モードを選択する必要があります。

通常の同期

synchronous_standby_names = 'FIRST X (standby_name1, standby_name2, ...)'

通常の同期モードで運用する場合、上記のようにsyn ch ro n ou s_stan d b y_namesを設定します。 FIRSTは通常の同期モードの選択であり、省略可能です。 数字Xは

同期対象のスレーブ数であり、カッコ内の左から順に優先して同期対象になります。 カッコ内のスレーブ名は、同期候補のスレーブです。

以下のような設定の場合、slave1~3が同期運用、slave4~5は潜在的な同期運用がされます。 潜在的な同期運用は、普段は非同期として運用され、必要な場合

は同期へ昇格されます。 例えばslave2の環境がマスタから切断された場合、残ったスレーブで優先度が高いslave1,slave3,sla ve4が同期運用されます。 (つまり非同期

運用であったslave4が同期運用へ昇格されます)

synchronous_standby_names = 'FIRST 3 (slave1, slave2, slave3, slave4, slave5)'

障害発生時は、同期の優先度が高いスレーブを新マスタへ昇格させます。 通常の同期モードではカッコ内の左側が優先度が高く、右に行くほど優先度が低くなります。

クォーラムコミット